简介

到目前为止,网页上的音频一直相当原始,直到最近才需要通过 Flash 和 QuickTime 等插件来传递音频。HTML5 中引入的

audio

元素非常重要,允许进行基本的流音频播放。但是,它还不足以处理更复杂的音频应用程序。对于复杂的基于网页的游戏或交互式应用程序,需要另一种解决方案。本规范的目标是包含现代游戏音频引擎中的功能,以及现代桌面音频制作应用中用于混音、处理和过滤的任务。

API 的设计考虑了多种使用案例 [webaudio-usecases]。理想情况下,它应该能够支持任何可以合理地用优化的 C++ 引擎通过脚本在浏览器中运行的使用案例。话虽如此,现代桌面音频软件可能具有非常高级的功能,其中一些功能使用此系统构建起来非常困难甚至不可能。例如,Apple 的 Logic Audio 支持外部 MIDI 控制器、任意插件音频效果和合成器、高度优化的直接磁盘音频文件读写、紧密集成的时间拉伸等功能。然而,拟议的系统将完全能够支持大量相当复杂的游戏和交互式应用程序,包括音乐类应用程序。此外,它可以很好地补充 WebGL 提供的更高级的图形功能。API 的设计也允许以后添加更高级的功能。

特性

API 支持以下主要特性:

-

模块化路由,用于简单或复杂的混合/效果架构。

-

高动态范围,使用 32 位浮点数进行内部处理。

-

采样精确的声音播放调度,具有低 延迟,适用于对节奏精度要求很高的音乐应用,例如鼓机和音序器。这还包括动态创建效果的可能性。

-

自动化音频参数,用于包络、渐入/渐出、粒子效果、滤波扫频、LFO 等。

-

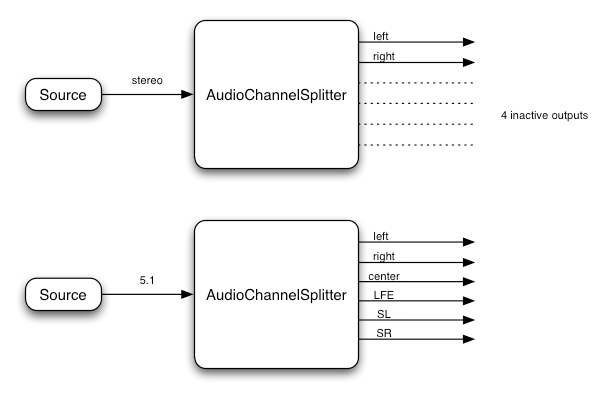

灵活处理音频流中的通道,允许拆分和合并它们。

-

使用

MediaStream从getUserMedia()获取的实时音频输入进行处理。 -

与 WebRTC 集成

-

使用

MediaStreamTrackAudioSourceNode处理从远程对等方接收的音频,并参考 [webrtc]。 -

使用

MediaStreamAudioDestinationNode发送生成或处理过的音频流到远程对等方,并参考 [webrtc]。

-

-

使用 脚本直接合成和处理音频流。

-

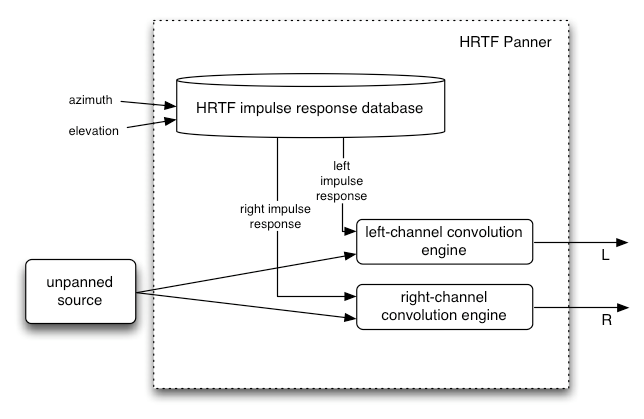

空间化音频,支持广泛的 3D 游戏和沉浸式环境:

-

声像模型:equalpower、HRTF、直通

-

距离衰减

-

声锥

-

遮挡 / 阻塞

-

基于源 / 监听者

-

-

用于广泛线性效果的卷积引擎,特别是非常高质量的房间效果。以下是一些可能的效果示例:

-

小 / 大房间

-

大教堂

-

音乐厅

-

洞穴

-

隧道

-

走廊

-

森林

-

圆形剧场

-

从门口听到的远处房间的声音

-

极端滤波器

-

奇怪的反向效果

-

极端梳状滤波效果

-

-

动态压缩以整体控制和优化混音效果

-

高效的 实时时域和频域分析 / 音乐可视化支持。

-

高效的双二阶滤波器,用于低通、高通和其他常见滤波器。

-

用于失真和其他非线性效果的波形整形效果

-

振荡器

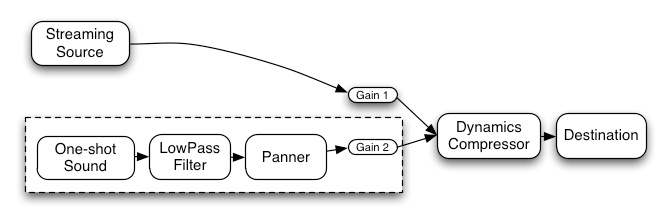

模块化路由

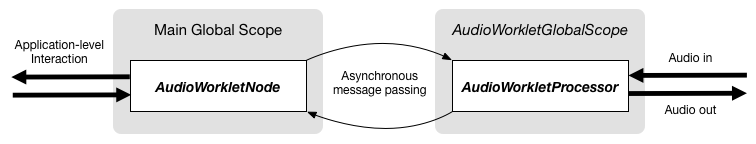

模块化路由允许不同的 AudioNode

对象之间进行任意连接。每个节点可以有 输入 和/或 输出。

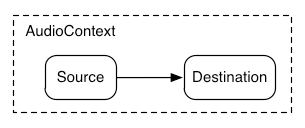

一个 源节点 没有输入且只有一个输出。

一个 目标节点

有一个输入且没有输出。其他节点如滤波器可以放置在源节点和目标节点之间。当两个对象连接在一起时,开发者不必担心底层的流格式细节;正确的事情会自动发生。

例如,如果一个单声道音频流连接到一个立体声输入,它会适当地混合到左右声道合适的位置。

在最简单的情况下,单个源可以直接路由到输出。所有路由都在一个包含单个 AudioContext

和 AudioDestinationNode

的上下文中进行:

为了说明这个简单的路由,这里是一个简单的播放单个声音的示例:

const context= new AudioContext(); function playSound() { const source= context. createBufferSource(); source. buffer= dogBarkingBuffer; source. connect( context. destination); source. start( 0 ); }

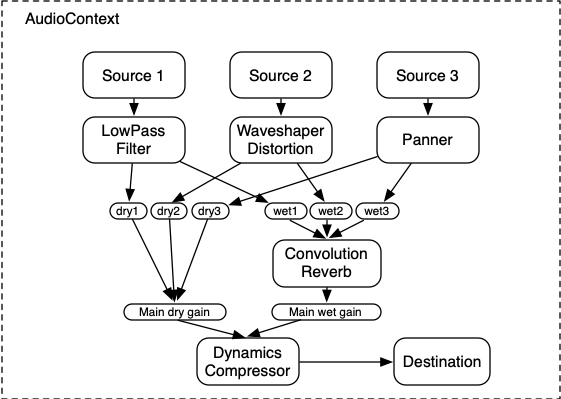

这里是一个更复杂的例子,有三个音源和一个卷积混响发送,最终输出阶段有一个动态压缩器:

...

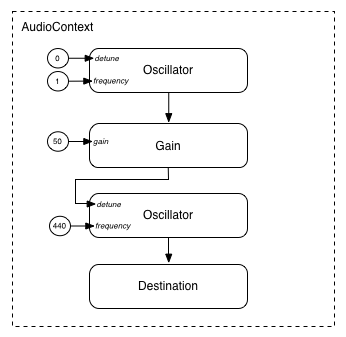

模块化路由还允许 AudioNode

的输出被路由到 AudioParam

参数,从而控制其他 AudioNode

的行为。在这种情况下,节点的输出可以充当调制信号,而不是输入信号。

function setupRoutingGraph() { const context= new AudioContext(); // Create the low frequency oscillator that supplies the modulation signal const lfo= context. createOscillator(); lfo. frequency. value= 1.0 ; // Create the high frequency oscillator to be modulated const hfo= context. createOscillator(); hfo. frequency. value= 440.0 ; // Create a gain node whose gain determines the amplitude of the modulation signal const modulationGain= context. createGain(); modulationGain. gain. value= 50 ; // Configure the graph and start the oscillators lfo. connect( modulationGain); modulationGain. connect( hfo. detune); hfo. connect( context. destination); hfo. start( 0 ); lfo. start( 0 ); }

API 概述

定义的接口包括:

-

一个 AudioContext 接口,包含表示

AudioNode之间连接的音频信号图。 -

一个

AudioNode接口,代表音频源、音频输出和中间处理模块。AudioNode可以以 模块化的方式 动态连接在一起。AudioNode存在于AudioContext中。 -

一个

AnalyserNode接口, 是一个AudioNode, 用于音乐可视化工具或其他可视化应用程序。 -

一个

AudioBuffer接口,用于处理内存中的音频资产。 这些音频资产可以表示一次性播放的声音,或者较长的音频片段。 -

一个

AudioBufferSourceNode接口, 是一个AudioNode,用于从 AudioBuffer 生成音频。 -

一个

AudioDestinationNode接口, 是一个AudioNode子类, 代表所有渲染音频的最终目标。 -

一个

AudioParam接口, 用于控制AudioNode的某个具体方面的功能,例如音量。 -

一个

AudioListener接口, 与PannerNode一起用于空间化处理。 -

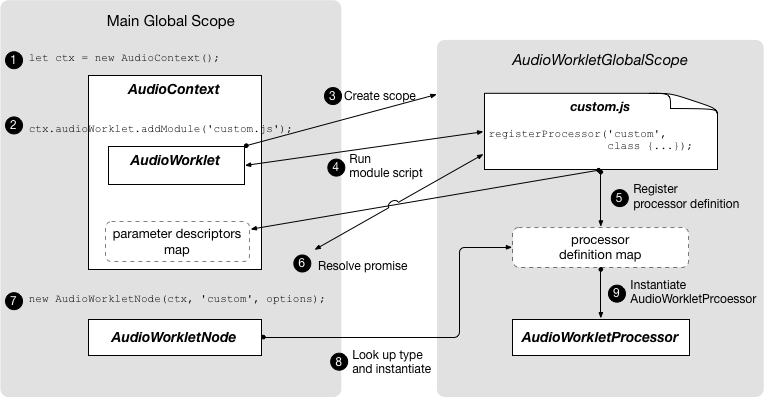

一个

AudioWorklet接口, 代表一个用于创建自定义节点的工厂,这些节点可以直接使用脚本处理音频。 -

一个

AudioWorkletGlobalScope接口, 代表 AudioWorkletProcessor 处理脚本运行的上下文。 -

一个

AudioWorkletNode接口, 是一个AudioNode,代表在 AudioWorkletProcessor 中处理的节点。 -

一个

AudioWorkletProcessor接口, 代表音频工作者中的单个节点实例。 -

一个

BiquadFilterNode接口, 是一个AudioNode,用于常见的低阶滤波器,例如:-

低通滤波器(Low Pass)

-

高通滤波器(High Pass)

-

带通滤波器(Band Pass)

-

低架滤波器(Low Shelf)

-

高架滤波器(High Shelf)

-

峰值滤波器(Peaking)

-

陷波滤波器(Notch)

-

全通滤波器(Allpass)

-

-

一个

ChannelMergerNode接口, 是一个AudioNode,用于将多个音频流的通道合并为一个音频流。 -

一个

ChannelSplitterNode接口, 是一个AudioNode,用于在路由图中访问音频流的各个通道。 -

一个

ConstantSourceNode接口, 是一个AudioNode,用于生成名义上恒定的输出值, 并使用AudioParam来自动化控制该值。 -

一个

ConvolverNode接口, 是一个AudioNode,用于应用实时线性效果(例如音乐厅的声音)。 -

一个

DynamicsCompressorNode接口, 是一个AudioNode,用于动态压缩。 -

一个

IIRFilterNode接口, 是一个AudioNode,用于通用 IIR 滤波。 -

一个

MediaElementAudioSourceNode接口, 是一个AudioNode,用于从audio、video或其他媒体元素中生成音频。 -

一个

MediaStreamAudioSourceNode接口, 是一个AudioNode, 用于从MediaStream中获取音频源, 如实时音频输入或来自远程对等体的音频。 -

一个

MediaStreamTrackAudioSourceNode接口, 是一个AudioNode, 用于从MediaStreamTrack获取音频源。 -

一个

MediaStreamAudioDestinationNode接口, 是一个AudioNode, 用于作为MediaStream的音频目标,发送给远程对等体。 -

一个

PannerNode接口, 是一个AudioNode, 用于在 3D 空间中对音频进行空间化 / 定位。 -

一个

PeriodicWave接口, 用于为OscillatorNode指定自定义的周期波形。 -

一个

OscillatorNode接口, 是一个AudioNode, 用于生成周期波形。 -

一个

StereoPannerNode接口, 是一个AudioNode, 用于在立体声流中等功率定位音频输入。 -

一个

WaveShaperNode接口, 是一个AudioNode, 用于应用非线性波形整形效果,用于失真和其他更微妙的增暖效果。

Web Audio API 还有几个功能已被弃用,但尚未删除,等待替代方案的实现经验:

-

一个

ScriptProcessorNode接口, 是一个AudioNode, 用于直接使用脚本生成或处理音频。 -

一个

AudioProcessingEvent接口, 是与ScriptProcessorNode对象一起使用的事件类型。

1. 音频 API

1.1.

BaseAudioContext

接口

此接口表示一组 AudioNode

对象及其连接。它允许将信号任意路由到 AudioDestinationNode。节点是从上下文中创建的,然后相互

连接。

BaseAudioContext

不能直接实例化,而是通过具体接口 AudioContext(用于实时渲染)和

OfflineAudioContext

(用于离线渲染)来扩展。

BaseAudioContext

创建时带有一个内部槽 [[pending promises]],它是一个初始为空的有序承诺列表。

每个 BaseAudioContext

都有一个唯一的 媒体元素事件任务源。

此外,BaseAudioContext

具有几个私有槽 [[rendering thread state]] 和

[[control thread state]],

它们的值取自 AudioContextState,

且都最初设置为 "suspended",并有一个私有槽 [[render quantum size]],它是一个无符号整数。

enum {AudioContextState "suspended" ,"running" ,"closed" };

| 枚举值 | 描述 |

|---|---|

"suspended"

| 该上下文当前被挂起(上下文时间不继续,音频硬件可能已关闭/释放)。 |

"running"

| 正在处理音频。 |

"closed"

| 该上下文已被释放,不能再用于处理音频。所有系统音频资源均已释放。 |

enum {AudioContextRenderSizeCategory "default" ,"hardware" };

| 枚举说明 | |

|---|---|

"default"

| AudioContext 的渲染量子大小为默认值 128 帧。 |

"hardware"

| User-Agent 选择一个适合当前配置的渲染量子大小。

注意: 这会暴露有关主机的信息,并可能用于指纹识别。 |

callback DecodeErrorCallback =undefined (DOMException );error callback DecodeSuccessCallback =undefined (AudioBuffer ); [decodedData Exposed =Window ]interface BaseAudioContext :EventTarget {readonly attribute AudioDestinationNode destination ;readonly attribute float sampleRate ;readonly attribute double currentTime ;readonly attribute AudioListener listener ;readonly attribute AudioContextState state ;readonly attribute unsigned long renderQuantumSize ; [SameObject ,SecureContext ]readonly attribute AudioWorklet audioWorklet ;attribute EventHandler onstatechange ;AnalyserNode createAnalyser ();BiquadFilterNode createBiquadFilter ();AudioBuffer createBuffer (unsigned long ,numberOfChannels unsigned long ,length float );sampleRate AudioBufferSourceNode createBufferSource ();ChannelMergerNode createChannelMerger (optional unsigned long numberOfInputs = 6);ChannelSplitterNode createChannelSplitter (optional unsigned long numberOfOutputs = 6);ConstantSourceNode createConstantSource ();ConvolverNode createConvolver ();DelayNode createDelay (optional double maxDelayTime = 1.0);DynamicsCompressorNode createDynamicsCompressor ();GainNode createGain ();IIRFilterNode createIIRFilter (sequence <double >,feedforward sequence <double >);feedback OscillatorNode createOscillator ();PannerNode createPanner ();PeriodicWave createPeriodicWave (sequence <float >,real sequence <float >,imag optional PeriodicWaveConstraints = {});constraints ScriptProcessorNode createScriptProcessor (optional unsigned long bufferSize = 0,optional unsigned long numberOfInputChannels = 2,optional unsigned long numberOfOutputChannels = 2);StereoPannerNode createStereoPanner ();WaveShaperNode createWaveShaper ();Promise <AudioBuffer >decodeAudioData (ArrayBuffer ,audioData optional DecodeSuccessCallback ?,successCallback optional DecodeErrorCallback ?); };errorCallback

1.1.1. 属性

audioWorklet, 类型 AudioWorklet, 只读-

允许访问

Worklet对象,可以通过 [HTML] 和AudioWorklet中定义的算法导入包含AudioWorkletProcessor类定义的脚本。 currentTime, 类型 double, 只读-

这是由上下文的渲染图最近处理的音频块中紧跟在最后一个样本帧之后的样本帧的时间(以秒为单位)。如果上下文的渲染图尚未处理任何音频块,则

currentTime的值为零。在

currentTime的时间坐标系统中,值为零对应于图中处理的第一个块中的第一个样本帧。此系统中的经过时间对应于由BaseAudioContext生成的音频流中的经过时间,这可能不同步于系统中的其他时钟。(对于OfflineAudioContext,因为流并未被任何设备主动播放,所以没有接近真实时间的概念。)Web Audio API 中的所有计划时间都是相对于

currentTime的值。当

BaseAudioContext处于“running”状态时,此属性的值会单调递增,并由渲染线程以均匀的增量更新,对应于一个 渲染量子。因此,对于正在运行的上下文,currentTime随系统处理音频块而稳步增加,并始终表示将要处理的下一个音频块的起始时间。同时,它也是当前状态下计划中的任何更改可能生效的最早时间。currentTime必须在控制线程上 原子性 读取后再返回。 destination, 类型 AudioDestinationNode, 只读-

一个

AudioDestinationNode,具有一个输入,表示所有音频的最终目标。通常,它表示实际的音频硬件。所有正在积极渲染音频的AudioNode都将直接或间接连接到destination。 listener, 类型 AudioListener, 只读-

一个

AudioListener,用于 3D 空间化。 onstatechange, 类型 EventHandler-

用于设置 事件处理程序 的属性,当 AudioContext 的状态发生变化时(即,当相应的承诺将被解决时),会向

BaseAudioContext派发一个事件。此事件处理程序的事件类型为statechange。使用Event接口的事件将被派发给事件处理程序,事件处理程序可以直接查询 AudioContext 的状态。新创建的 AudioContext 将始终以suspended状态开始,并且每当状态更改为不同状态时,都会触发状态更改事件。此事件会在complete事件之前触发。 sampleRate, 类型 float, 只读-

BaseAudioContext处理音频的采样率(每秒采样帧数)。假设上下文中的所有AudioNode都以该速率运行。在做出这个假设的前提下,实时处理不支持采样率转换器或“变速”处理器。奈奎斯特频率是这个采样率值的一半。 state, 类型 AudioContextState, 只读-

描述

BaseAudioContext的当前状态。获取此属性会返回[[control thread state]]槽的内容。 renderQuantumSize, 类型 unsigned long, 只读-

获取此属性会返回

[[render quantum size]]槽的值。

1.1.2. 方法

createAnalyser()-

工厂方法 用于创建一个

AnalyserNode。无参数。返回类型:AnalyserNode createBiquadFilter()-

工厂方法 用于创建一个

BiquadFilterNode,它表示一个二阶滤波器,可以配置为几种常见的滤波器类型之一。无参数。返回类型:BiquadFilterNode createBuffer(numberOfChannels, length, sampleRate)-

创建给定大小的 AudioBuffer。缓冲区中的音频数据将被初始化为零(静音)。如果任何参数为负、零或超出其正常范围,必须抛出一个

NotSupportedError异常。BaseAudioContext.createBuffer() 方法的参数。 参数 类型 可空 可选 描述 numberOfChannelsunsigned long✘ ✘ 决定缓冲区将有多少个通道。实现必须至少支持 32 个通道。 lengthunsigned long✘ ✘ 确定缓冲区的大小(以采样帧为单位)。此值必须至少为 1。 sampleRatefloat✘ ✘ 描述缓冲区中线性 PCM 音频数据的采样率,以每秒采样帧数表示。实现必须至少支持 8000 到 96000 之间的采样率。 返回类型:AudioBuffer createBufferSource()-

工厂方法 用于创建一个

AudioBufferSourceNode。无参数。返回类型:AudioBufferSourceNode createChannelMerger(numberOfInputs)-

工厂方法 用于创建一个

ChannelMergerNode,用于表示一个通道合并器。如果numberOfInputs小于 1 或大于支持的通道数,则必须抛出一个IndexSizeError异常。BaseAudioContext.createChannelMerger(numberOfInputs) 方法的参数。 参数 类型 可空 可选 描述 numberOfInputsunsigned long✘ ✔ 决定输入的数量。必须支持最多 32 个通道。如果未指定,则使用 6。返回类型:ChannelMergerNode createChannelSplitter(numberOfOutputs)-

工厂方法 用于创建一个

ChannelSplitterNode,用于表示一个通道分离器。如果numberOfOutputs小于 1 或大于支持的通道数,则必须抛出一个IndexSizeError异常。BaseAudioContext.createChannelSplitter(numberOfOutputs) 方法的参数。 参数 类型 可空 可选 描述 numberOfOutputsunsigned long✘ ✔ 输出的数量。必须支持最多 32 个输出。如果未指定,则使用 6。返回类型:ChannelSplitterNode createConstantSource()-

工厂方法 用于创建一个

ConstantSourceNode。无参数。返回类型:ConstantSourceNode createConvolver()-

工厂方法 用于创建一个

ConvolverNode。无参数。返回类型:ConvolverNode createDelay(maxDelayTime)-

工厂方法 用于创建一个

DelayNode。初始默认的延迟时间为 0 秒。BaseAudioContext.createDelay(maxDelayTime) 方法的参数。 参数 类型 可空 可选 描述 maxDelayTimedouble✘ ✔ 指定延迟线允许的最大延迟时间(单位:秒)。如果指定了该值,它必须大于零且小于三分钟,否则必须抛出 NotSupportedError异常。如果未指定,则使用1。返回类型:DelayNode createDynamicsCompressor()-

工厂方法 用于创建一个

DynamicsCompressorNode。无参数。返回类型:DynamicsCompressorNode createGain()-

无参数。返回类型:

GainNode createIIRFilter(feedforward, feedback)-

BaseAudioContext.createIIRFilter() 方法的参数。 参数 类型 可空 可选 描述 feedforwardsequence<double>✘ ✘ 传递函数的前馈(分子)系数数组。该数组的最大长度为 20。如果所有值均为零,必须抛出 InvalidStateError。 如果数组长度为 0 或大于 20,必须抛出NotSupportedError。feedbacksequence<double>✘ ✘ 传递函数的反馈(分母)系数数组。该数组的最大长度为 20。如果数组的第一个元素为 0,必须抛出 InvalidStateError。 如果数组长度为 0 或大于 20,必须抛出NotSupportedError。返回类型:IIRFilterNode createOscillator()-

工厂方法 用于创建一个

OscillatorNode。无参数。返回类型:OscillatorNode createPanner()-

工厂方法 用于创建一个

PannerNode。无参数。返回类型:PannerNode createPeriodicWave(real, imag, constraints)-

工厂方法 用于创建一个

PeriodicWave。调用此方法时,请执行以下步骤:-

如果

real和imag长度不相等,则必须抛出一个IndexSizeError。 -

创建一个新的类型为

PeriodicWaveOptions的对象 o。 -

将 o 的

disableNormalization属性设置为传递给工厂方法的constraints属性中的disableNormalization属性的值。 -

构建一个新的

PeriodicWavep,传递给工厂方法所调用的BaseAudioContext作为第一个参数,以及 o。 -

返回 p。

BaseAudioContext.createPeriodicWave() 方法的参数。 参数 类型 可空 可选 描述 realsequence<float>✘ ✘ 余弦参数的序列。有关详细描述,请参阅其构造函数参数 real。imagsequence<float>✘ ✘ 正弦参数的序列。有关详细描述,请参阅其构造函数参数 imag。constraintsPeriodicWaveConstraints✘ ✔ 如果未给出,波形将被规范化。否则,将根据 constraints给定的值进行规范化。返回类型:PeriodicWave -

createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels)-

工厂方法 用于创建一个

ScriptProcessorNode。 此方法已弃用,因为它将由AudioWorkletNode替代。 该方法用于通过脚本直接处理音频,生成一个ScriptProcessorNode。 如果参数bufferSize、numberOfInputChannels或numberOfOutputChannels超出有效范围,则必须抛出IndexSizeError异常。参数

numberOfInputChannels和numberOfOutputChannels不允许同时为零。在这种情况下,必须抛出IndexSizeError。BaseAudioContext.createScriptProcessor(bufferSize, numberOfInputChannels, numberOfOutputChannels) 方法的参数。 参数 类型 可空 可选 描述 bufferSizeunsigned long✘ ✔ bufferSize参数决定了缓冲区大小,以样本帧为单位。如果未传递该参数或值为0,则由实现选择最佳缓冲区大小,且该大小在节点的整个生命周期内始终为2的幂次方。 否则,如果作者明确指定了 bufferSize,其值必须为以下之一:256、512、1024、2048、4096、8192、16384。 该值控制audioprocess事件的调度频率,以及每次调用需要处理的样本帧数量。 较小的 bufferSize 值会导致较低的(更好的)延迟,而较大的值则可能需要避免音频中断和音频问题。 建议作者不要指定此 bufferSize,允许实现选择合适的大小,以平衡延迟和音频质量。 如果该参数的值不是上述允许的2的幂次方之一,必须抛出IndexSizeError。numberOfInputChannelsunsigned long✘ ✔ 该参数决定了此节点输入的通道数。默认值为2,支持多达32个通道。 如果通道数不受支持,必须抛出 NotSupportedError。numberOfOutputChannelsunsigned long✘ ✔ 该参数决定了此节点输出的通道数。默认值为2,支持多达32个通道。 如果通道数不受支持,必须抛出 NotSupportedError。返回类型:ScriptProcessorNode createStereoPanner()-

工厂方法 用于创建一个

StereoPannerNode。无参数。返回类型:StereoPannerNode createWaveShaper()-

工厂方法 用于创建一个

WaveShaperNode, 用于表示非线性失真。无参数。返回类型:WaveShaperNode decodeAudioData(audioData, successCallback, errorCallback)-

异步解码包含在

ArrayBuffer中的音频文件数据。 例如,可以通过将XMLHttpRequest的responseType设置为"arraybuffer"后, 从response属性加载ArrayBuffer。 音频文件数据可以是任何由audio元素支持的格式。传递给decodeAudioData()的缓冲区 通过嗅探来确定其内容类型,如 [mimesniff] 所述。虽然主要通过返回的 Promise 来与此函数交互,但提供了回调参数以便于向后兼容。

建议在文件损坏时提醒作者,因为无法抛出错误,这样做会导致不兼容的变更。

注意:如果压缩的音频数据字节流已损坏,但仍然可以继续解码,建议实现通过开发工具等方式提醒作者。当调用decodeAudioData时,必须在控制线程上执行以下步骤:-

如果 this 的 相关全局对象 的 关联文档 不是 完全活跃,则返回 一个被拒绝的 Promise,其错误为 "

InvalidStateError"DOMException。 -

定义 promise 作为一个新的 Promise。

-

-

将 promise 添加到

[[pending promises]]。 -

分离

audioDataArrayBuffer。 如果此操作抛出异常,跳转到步骤3。 -

队列一个在其他线程上执行的解码操作。

-

-

否则,执行以下错误步骤:

-

定义 error 作为一个

DataCloneError。 -

用 error 拒绝 promise,并从

[[pending promises]]中移除。 -

队列一个媒体元素任务 来调用

errorCallback及 error。

-

-

返回 promise。

当将解码操作排队以在其他线程上执行时,必须在非 控制线程 和 渲染线程 上执行以下步骤, 称为解码线程。注意:多个

解码线程可以并行运行,以处理对decodeAudioData的多个调用。-

定义 can decode 作为一个布尔标志,初始值为 true。

-

尝试使用 MIME Sniffing § 6.2 匹配音频或视频类型模式 确定

audioData的 MIME 类型。如果音频或视频类型模式匹配算法返回undefined, 则将 can decode 设置为 false。 -

如果 can decode 为 true,则尝试将编码的

audioData解码为 线性 PCM。 在失败的情况下,将 can decode 设置为 false。如果媒体字节流包含多个音轨,则只解码第一个音轨为 线性 PCM。

注意:需要更多控制解码过程的作者可以使用 [WEBCODECS]。

-

如果 can decode 为

false,则 队列一个媒体元素任务 以执行以下步骤:-

定义 error 作为

DOMException,其名称为EncodingError。-

用 error 拒绝 promise,并从

[[pending promises]]中移除。

-

-

如果

errorCallback不为空,则使用 error 调用errorCallback。

-

-

否则:

-

将解码结果表示为解码的 线性 PCM 音频数据, 如果其采样率与

BaseAudioContext的采样率不同,则重新采样。 -

队列一个媒体元素任务以执行以下步骤:

-

定义 buffer 为包含最终结果的

AudioBuffer(可能经过采样率转换)。 -

用 buffer 解析 promise。

-

如果

successCallback不为空,则使用 buffer 调用successCallback。

-

-

参数表:BaseAudioContext.decodeAudioData() 方法。 参数名称 类型 可为空 可选 描述 audioDataArrayBuffer✘ ✘ 包含压缩音频数据的 ArrayBuffer。 successCallbackDecodeSuccessCallback?✔ ✔ 在解码完成时被调用的回调函数。该回调函数的唯一参数是一个代表解码后的 PCM 音频数据的 AudioBuffer。 errorCallbackDecodeErrorCallback?✔ ✔ 在解码音频文件出错时被调用的回调函数。 返回类型:Promise<AudioBuffer> -

1.1.3. 回调 DecodeSuccessCallback()

参数

decodedData, 类型为AudioBuffer-

包含解码音频数据的 AudioBuffer。

1.1.4. 回调 DecodeErrorCallback()

参数

error, 类型为DOMException-

解码时发生的错误。

1.1.5. 生命周期

一旦创建,一个 AudioContext

将持续播放声音,直到没有更多的声音可播放,或者页面被关闭。

1.1.6. 缺少自省或序列化原语

Web Audio API 采用一种 一次触发 的音频源调度方式。也就是说,在 AudioContext

的生命周期内,每个音符会创建 源节点,并且从不会显式地从图中移除。这种方式与序列化 API 不兼容,因为没有稳定的节点集可以被序列化。

此外,拥有自省 API 可能会使内容脚本观察垃圾回收行为。

1.1.7. 与 BaseAudioContext

子类相关的系统资源

子类 AudioContext

和 OfflineAudioContext

应被视为昂贵的对象。创建这些对象可能涉及创建一个高优先级线程,或使用低延迟的系统音频流,这两者都会影响能耗。在一个文档中通常不需要创建多个 AudioContext。

构造或恢复一个 BaseAudioContext

子类会涉及为该上下文 获取系统资源。对于 AudioContext,这还需要创建一个系统音频流。这些操作将在上下文开始从其关联的音频图生成输出时返回。

此外,用户代理可以具有一个实现定义的最大 AudioContext

数量,超过该数量后,任何创建新 AudioContext

的尝试都将失败,抛出 NotSupportedError。

suspend

和 close

允许作者 释放系统资源,包括线程、进程和音频流。暂停一个

BaseAudioContext

允许实现释放其部分资源,并通过调用 resume

使其以后继续运行。关闭一个 AudioContext

允许实现释放所有资源,此后它不能再被使用或恢复。

注意:例如,这可能涉及等待音频回调定期触发,或等待硬件准备好进行处理。

1.2. AudioContext

接口

此接口表示一个音频图,其 AudioDestinationNode

被路由到一个实时输出设备,该设备产生指向用户的信号。在大多数用例中,每个文档只使用一个 AudioContext。

enum {AudioContextLatencyCategory "balanced" ,"interactive" ,"playback" };

| 枚举值 | 描述 |

|---|---|

"balanced"

| 平衡音频输出延迟和能耗。 |

"interactive"

| 在不产生音频失真的情况下,提供最低的音频输出延迟。这是默认值。 |

"playback"

| 优先持续播放而不中断,而不是音频输出延迟。最低能耗。 |

enum {AudioSinkType "none" };

| 枚举值 | 描述 |

|---|---|

"none"

| 音频图将被处理但不会通过音频输出设备播放。 |

[Exposed =Window ]interface AudioContext :BaseAudioContext {constructor (optional AudioContextOptions contextOptions = {});readonly attribute double baseLatency ;readonly attribute double outputLatency ; [SecureContext ]readonly attribute (DOMString or AudioSinkInfo )sinkId ; [SecureContext ]readonly attribute AudioRenderCapacity renderCapacity ;attribute EventHandler onsinkchange ;attribute EventHandler onerror ;AudioTimestamp getOutputTimestamp ();Promise <undefined >resume ();Promise <undefined >suspend ();Promise <undefined >close (); [SecureContext ]Promise <undefined >((setSinkId DOMString or AudioSinkOptions ));sinkId MediaElementAudioSourceNode createMediaElementSource (HTMLMediaElement );mediaElement MediaStreamAudioSourceNode createMediaStreamSource (MediaStream );mediaStream MediaStreamTrackAudioSourceNode createMediaStreamTrackSource (MediaStreamTrack );mediaStreamTrack MediaStreamAudioDestinationNode createMediaStreamDestination (); };

当用户代理允许上下文状态从 "suspended"

过渡到 "running"

时,AudioContext

被称为 允许启动。用户代理可以拒绝这种初始转换,只有当 AudioContext

的 相关全局对象具有 粘性激活 时,才允许这种转换。

AudioContext

具有以下内部槽:

[[suspended by user]]-

一个布尔标志,表示上下文是否被用户代码挂起。初始值为

false。 [[sink ID]]-

一个

DOMString或AudioSinkInfo,分别表示当前音频输出设备的标识符或信息。初始值为"",表示默认的音频输出设备。 [[pending resume promises]]

1.2.1. 构造函数

AudioContext(contextOptions)-

如果 当前设置对象的相关全局对象的关联的文档不是完全激活,则抛出“

创建InvalidStateError”并中止这些步骤。AudioContext时,执行以下步骤:-

令 context 为一个新的

AudioContext对象。 -

在 context 上将

[[控制线程状态]]设置为suspended。 -

在 context 上将

[[渲染线程状态]]设置为suspended。 -

令 messageChannel 为一个新的

MessageChannel。 -

令 controlSidePort 为 messageChannel 的

port1属性的值。 -

令 renderingSidePort 为 messageChannel 的

port2属性的值。 -

令 serializedRenderingSidePort 为 StructuredSerializeWithTransfer(renderingSidePort, « renderingSidePort ») 的结果。

-

将此

audioWorklet的port设置为 controlSidePort。 -

排队控制消息以在 AudioContextGlobalScope 上设置 MessagePort,使用 serializedRenderingSidePort。

-

如果提供了

contextOptions,执行以下子步骤:-

如果指定了

sinkId,则令 sinkId 为contextOptions.的值,并运行以下子步骤:sinkId-

如果 sinkId 和

[[sink ID]]均为DOMString类型,且相等,则中止这些子步骤。 -

如果 sinkId 是

AudioSinkOptions类型,且[[sink ID]]是AudioSinkInfo类型,且type在 sinkId 中与type在[[sink ID]]中相等,则中止这些子步骤。 -

令 validationResult 为 sink 标识符验证 sinkId 的返回值。

-

如果 validationResult 是

DOMException类型,抛出一个包含 validationResult 的异常并中止这些子步骤。 -

如果 sinkId 是

DOMString类型,将[[sink ID]]设置为 sinkId 并中止这些子步骤。 -

如果 sinkId 是

AudioSinkOptions类型,将[[sink ID]]设置为由type的值创建的新AudioSinkInfo实例。

-

-

根据

contextOptions.设置 context 的内部延迟,如latencyHintlatencyHint所述。 -

如果指定了

contextOptions.,则将 context 的sampleRatesampleRate设置为此值。否则,执行以下子步骤:-

如果 sinkId 是空字符串或

AudioSinkOptions类型,则使用默认输出设备的采样率。中止这些子步骤。 -

如果 sinkId 是

DOMString,则使用由 sinkId 标识的输出设备的采样率。中止这些子步骤。

如果

contextOptions.与输出设备的采样率不同,则用户代理必须将音频输出重新采样以匹配输出设备的采样率。sampleRate注意:如果需要重新采样,context 的延迟可能会受到影响,可能会有较大的影响。

-

-

-

返回 context。

发送一个 控制消息 以开始处理意味着执行以下步骤:-

尝试获取系统资源以使用以下音频输出设备进行渲染,基于

[[sink ID]]:-

空字符串表示默认音频输出设备。

-

由

[[sink ID]]标识的音频输出设备。

-

如果资源获取失败,执行以下步骤:

-

如果 document 不允许使用标识为

"speaker-selection"的功能,则中止这些子步骤。 -

排队媒体元素任务以触发一个事件,事件名为

error,目标是AudioContext,然后中止后续步骤。

-

-

-

将 this 的

[[渲染线程状态]]设置为running,用于AudioContext。 -

排队媒体元素任务以执行以下步骤:

-

将

state属性设置为running,目标是AudioContext。 -

触发一个事件,事件名为

statechange,目标是AudioContext。

-

注意: 在没有参数的情况下构造

AudioContext并且资源获取失败的情况下,用户代理将尝试通过模拟音频输出设备的机制静默渲染音频图。发送一个 控制消息 以在MessagePort上设置AudioWorkletGlobalScope的含义是执行以下步骤,在 渲染线程 上,使用传递给AudioWorkletGlobalScope的 serializedRenderingSidePort:AudioContext.constructor(contextOptions) 方法的参数。 参数 类型 可为空 可选 描述 contextOptionsAudioContextOptions✘ ✔ 用户指定的控制如何构造 AudioContext的选项。 -

1.2.2. 属性

baseLatency, 类型 double, 只读-

表示

AudioContext将音频从AudioDestinationNode传递到音频子系统时产生的处理延迟(以秒为单位)。它不包括由AudioDestinationNode输出到音频硬件之间的其他处理可能导致的额外延迟,也不包括音频图本身产生的延迟。例如,如果音频上下文以 44.1 kHz 的速率运行,并具有默认的渲染量子大小,并且

AudioDestinationNode在内部实现了双缓冲,并且每个 渲染量子 都能处理和输出音频,那么处理延迟大约为 \((2\cdot128)/44100 = 5.805 \mathrm{ ms}\)。 outputLatency, 类型 double, 只读-

音频输出延迟的估计值(以秒为单位),即用户代理请求主机系统播放缓冲区的时间与缓冲区中第一个样本实际被音频输出设备处理的时间之间的间隔。对于诸如扬声器或耳机之类的设备,这后一时间指的是样本声音被产生的时间。

outputLatency属性值依赖于平台和连接的音频输出设备硬件。outputLatency属性值可能会在上下文运行期间或相关音频输出设备更改时发生变化。为了实现准确的同步,频繁查询该值是有用的。 renderCapacity, 类型 AudioRenderCapacity, 只读-

返回与

AudioContext相关联的AudioRenderCapacity实例。 sinkId, 类型(DOMString 或 AudioSinkInfo), 只读-

返回内部插槽

[[sink ID]]的值。该属性在更新后会被缓存,并返回相同的对象。 onsinkchange, 类型 EventHandler-

用于

setSinkId()的 事件处理器。该事件处理器的事件类型是sinkchange。当输出设备更改完成时,将调度此事件。注意: 这不会为

AudioContext构造中的初始设备选择而调度。statechange事件可用于检查初始输出设备的准备状态。 onerror, 类型 EventHandler-

用于从

AudioContext派发的 事件处理器。该处理器的事件类型是error,用户代理在以下情况下可调度此事件:-

在初始化和激活选定音频设备时遇到故障。

-

当关联音频输出设备的

AudioContext在上下文运行时断开连接。 -

当操作系统报告音频设备故障时。

-

1.2.3. 方法

close()-

关闭

AudioContext,释放所使用的系统资源。这不会自动释放所有由AudioContext创建的对象,但会暂停AudioContext的currentTime的推进,并停止处理音频数据。调用 close 方法时,执行以下步骤:-

如果 this 的 相关全局对象 的 关联的文档不是 完全活动的,则返回 一个被拒绝的 Promise,带有 "

InvalidStateError"DOMException。 -

让 promise 成为一个新的 Promise。

-

如果

[[control thread state]]标志在AudioContext上为closed,则拒绝该 promise,带有InvalidStateError,中止这些步骤,返回 promise。 -

将

[[control thread state]]标志在AudioContext上设置为closed。 -

排队控制消息以关闭

AudioContext。 -

返回 promise。

运行关闭AudioContext的 控制消息,即在 渲染线程上运行以下步骤:-

尝试释放系统资源。

-

将

[[rendering thread state]]设置为suspended。这将停止渲染。 -

如果此 控制消息 是响应文档被卸载而运行的,则中止此算法。

在这种情况下,没有必要通知控制线程。 -

排队媒体元素任务以执行以下步骤:

-

解决 promise。

-

如果

state属性在AudioContext上还不是 "closed":-

将

state属性在AudioContext上设置为 "closed"。 -

排队媒体元素任务以 触发事件,名为

statechange,在AudioContext上。

-

-

当

AudioContext被关闭时,任何连接到AudioContext的MediaStream和HTMLMediaElement将不再输出。这意味着这些元素将不再对扬声器或其他输出设备产生任何输出。为了获得更灵活的行为,请考虑使用HTMLMediaElement.captureStream()。注意: 当

AudioContext被关闭时,实施可以选择比暂停时更积极地释放更多资源。无参数。 -

createMediaElementSource(mediaElement)-

给定一个

MediaElementAudioSourceNode,创建一个HTMLMediaElement。调用此方法后,来自HTMLMediaElement的音频将被重新路由到AudioContext的处理图中。AudioContext.createMediaElementSource() 方法的参数。 参数 类型 可空 可选 描述 mediaElementHTMLMediaElement✘ ✘ 将被重新路由的媒体元素。 createMediaStreamDestination()-

创建一个

MediaStreamAudioDestinationNode无参数。 createMediaStreamSource(mediaStream)-

创建一个

MediaStreamAudioSourceNode。AudioContext.createMediaStreamSource() 方法的参数。 参数 类型 可空 可选 描述 mediaStreamMediaStream✘ ✘ 将作为源的媒体流。 createMediaStreamTrackSource(mediaStreamTrack)-

创建一个

MediaStreamTrackAudioSourceNode。AudioContext.createMediaStreamTrackSource() 方法的参数。 参数 类型 可空 可选 描述 mediaStreamTrackMediaStreamTrack✘ ✘ 将作为源的 MediaStreamTrack。其kind属性的值必须等于"audio",否则必须抛出InvalidStateError异常。 getOutputTimestamp()-

返回一个新的

AudioTimestamp实例,其中包含上下文的两个相关的音频流位置值:contextTime成员包含由音频输出设备当前正在渲染的采样帧的时间(即输出音频流位置),其单位和起点与上下文的currentTime相同;performanceTime成员包含估算的时刻,即存储的contextTime值对应的采样帧被音频输出设备渲染的时间,其单位和起点与performance.now()(详见 [hr-time-3])相同。如果上下文的渲染图尚未处理音频块,则

getOutputTimestamp调用返回一个AudioTimestamp实例,两个成员均为零。在上下文的渲染图开始处理音频块后,其

currentTime属性值总是大于从getOutputTimestamp方法调用获得的contextTime值。通过getOutputTimestamp方法返回的值可以用于获取稍后上下文时间值的性能时间估算:function outputPerformanceTime( contextTime) { const timestamp= context. getOutputTimestamp(); const elapsedTime= contextTime- timestamp. contextTime; return timestamp. performanceTime+ elapsedTime* 1000 ; } 在上面的例子中,估算的准确性取决于参数值与当前输出音频流位置的接近程度:给定的

contextTime越接近timestamp.contextTime,所获得的估算的准确性就越高。注意: 上下文的

currentTime值和从getOutputTimestamp方法调用获得的contextTime之间的差异不能被视为可靠的输出延迟估算,因为currentTime可能在不均匀的时间间隔中递增,因此应该使用outputLatency属性。无参数。返回类型:AudioTimestamp resume()-

在

AudioContext已经暂停时,恢复其currentTime的进程。调用 resume 时,执行以下步骤:-

如果 this 的 相关全局对象 的 关联文档 不是 完全活跃,则返回 一个拒绝的 Promise,带有 "

InvalidStateError"DOMException。 -

设 promise 为一个新的 Promise。

-

如果

[[控制线程状态]]在AudioContext中为关闭,则拒绝该 Promise,带有InvalidStateError,中止这些步骤,并返回 promise。 -

将

[[被用户暂停]]设为false。 -

如果上下文不 允许启动,将 promise 添加到

[[待处理的 Promise]]和[[待恢复的 Promise]],并中止这些步骤,返回 promise。 -

将

[[控制线程状态]]在AudioContext中设为运行中。 -

排队一个控制消息,以恢复

AudioContext。 -

返回 promise。

运行一个 控制消息 以恢复AudioContext,意味着在 渲染线程 上执行这些步骤:-

尝试 获取系统资源。

-

将

[[渲染线程状态]]在AudioContext中设为运行中。 -

开始 渲染音频图。

-

如果失败,排队一个媒体元素任务来执行以下步骤:

-

按顺序拒绝所有

[[待恢复的 Promise]],然后清除[[待恢复的 Promise]]。 -

此外,从

[[待处理的 Promise]]中移除这些 Promise。

-

-

排队一个媒体元素任务来执行以下步骤:

-

按顺序解析所有

[[待恢复的 Promise]]。 -

清除

[[待恢复的 Promise]],此外,从[[待处理的 Promise]]中移除这些 Promise。 -

解析 promise。

-

如果

state属性在AudioContext中不为 "运行中":-

将

state属性在AudioContext中设为 "运行中"。 -

排队一个媒体元素任务以 触发一个事件,名为

statechange,在AudioContext中。

-

-

无参数。 -

suspend()-

暂停

AudioContext的currentTime的进程, 允许所有当前已处理的上下文块播放到目标设备,然后允许系统释放对音频硬件的控制。 当应用程序知道它在一段时间内不需要AudioContext时,这通常非常有用,并希望暂时释放与AudioContext相关的系统资源。 当帧缓冲区为空(已交给硬件)时,或者如果上下文已经处于suspended状态,则 Promise 将立即解析(没有其他效果)。 如果上下文已关闭,则 Promise 将被拒绝。调用 suspend 时,执行以下步骤:-

如果 this 的 相关全局对象 的 关联文档 不是 完全活跃,则返回 一个拒绝的 Promise,带有 "

InvalidStateError"DOMException。 -

设 promise 为一个新的 Promise。

-

如果

[[控制线程状态]]在AudioContext中为关闭,则拒绝该 Promise,带有InvalidStateError,中止这些步骤,并返回 promise。 -

将 promise 添加到

[[待处理的 Promise]]中。 -

将

[[被用户暂停]]设为true。 -

将

[[控制线程状态]]在AudioContext中设为suspended。 -

排队一个控制消息,以暂停

AudioContext。 -

返回 promise。

运行一个 控制消息 以暂停AudioContext,意味着在 渲染线程 上执行这些步骤:-

尝试 释放系统资源。

-

将

[[渲染线程状态]]在AudioContext中设为suspended。 -

排队一个媒体元素任务来执行以下步骤:

-

解析 promise。

-

如果

state属性在AudioContext中不为 "suspended":-

将

state属性在AudioContext中设为 "suspended"。 -

排队一个媒体元素任务以 触发一个事件,名为

statechange,在AudioContext中。

-

-

当

AudioContext被暂停时,MediaStream的输出将被忽略;即,数据将因媒体流的实时性而丢失。HTMLMediaElement的输出也将被忽略,直到系统恢复。AudioWorkletNode和ScriptProcessorNode在暂停时将不再调用其处理程序,但在上下文恢复时将继续调用。对于AnalyserNode窗口函数来说,数据被视为连续流——也就是说,resume()和suspend()不会导致在AnalyserNode的数据流中出现静音。特别地,当AudioContext被暂停时,反复调用AnalyserNode函数应返回相同的数据。无参数。 -

setSinkId((DOMString or AudioSinkOptions) sinkId)-

设置输出设备的标识符。当调用此方法时,用户代理必须执行以下步骤:

-

设 sinkId 为该方法的第一个参数。

-

如果 sinkId 等于

[[sink ID]],立即返回一个 Promise,解析它并中止这些步骤。 -

设 validationResult 为对 sinkId 进行 sink identifier validation 返回的值。

-

如果 validationResult 不为

null,则返回一个被 validationResult 拒绝的 Promise,中止这些步骤。 -

设 p 为一个新的 Promise。

-

发送一个带有 p 和 sinkId 的 控制消息 以开始处理。

-

返回 p。

在setSinkId()方法中,发送一个控制消息以开始处理意味着执行以下步骤:-

设 p 为传入此算法的 Promise。

-

设 sinkId 为传入此算法的接收器标识符。

-

如果 sinkId 和

[[sink ID]]都是DOMString类型,并且它们相等,排队一个媒体元素任务以解析 p,并中止这些步骤。 -

如果 sinkId 是

AudioSinkOptions类型,并且[[sink ID]]是AudioSinkInfo类型,并且type在 sinkId 中和type在[[sink ID]]中相等,排队一个媒体元素任务以解析 p,并中止这些步骤。 -

设 wasRunning 为 true。

-

如果

[[渲染线程状态]]在AudioContext中为"suspended",则将 wasRunning 设为 false。 -

在当前渲染量处理后暂停渲染器。

-

尝试 释放系统资源。

-

如果 wasRunning 为 true:

-

将

[[渲染线程状态]]在AudioContext中设为"suspended"。 -

排队一个媒体元素任务以执行以下步骤:

-

如果

state属性在AudioContext中不为 "suspended":-

将

state属性在AudioContext中设为 "suspended"。 -

触发一个事件,名为

statechange,在相关的AudioContext中。

-

-

-

-

尝试 获取系统资源以使用基于

[[sink ID]]的以下音频输出设备进行渲染:-

空字符串对应的默认音频输出设备。

-

由

[[sink ID]]标识的音频输出设备。

如果获取失败,则使用 "

InvalidAccessError" 拒绝 p,并中止以下步骤。 -

-

排队一个媒体元素任务以执行以下步骤:

-

如果 sinkId 是

DOMString类型,将[[sink ID]]设为 sinkId。中止这些步骤。 -

如果 sinkId 是

AudioSinkOptions类型,并且[[sink ID]]是DOMString类型,则将[[sink ID]]设为使用 sinkId 中的type值创建的新AudioSinkInfo实例。 -

如果 sinkId 是

AudioSinkOptions类型,并且[[sink ID]]是AudioSinkInfo类型,则将type设为 sinkId 中的type值。 -

解析 p。

-

触发一个事件,名为

sinkchange,在相关的AudioContext中。

-

-

如果 wasRunning 为 true:

-

将

[[渲染线程状态]]在AudioContext中设为"running"。 -

排队一个媒体元素任务以执行以下步骤:

-

如果

state属性在AudioContext中不为 "running":-

将

state属性在AudioContext中设为 "running"。 -

触发一个事件,名为

statechange,在相关的AudioContext中。

-

-

-

-

1.2.4.

验证 sinkId

此算法用于验证修改 sinkId

提供的信息:

-

让 document 成为当前设置对象的 关联文档。

-

让 sinkIdArg 成为传递给此算法的值。

-

如果 document 不被允许使用标识为

"speaker-selection"的功能,则返回一个新的DOMException,其名称为 "NotAllowedError"。 -

如果 sinkIdArg 是

DOMString类型,但它不是空字符串,或者它不匹配enumerateDevices()提供的任何音频输出设备,则返回一个新的DOMException,其名称为 "NotFoundError"。 -

返回

null。

1.2.5. AudioContextOptions

AudioContextOptions

字典用于为 AudioContext

指定用户指定的选项。

dictionary AudioContextOptions { (AudioContextLatencyCategory or double )latencyHint = "interactive";float sampleRate ; (DOMString or AudioSinkOptions )sinkId ; (AudioContextRenderSizeCategory or unsigned long )renderSizeHint = "default"; };

1.2.5.1. 字典 AudioContextOptions

成员

latencyHint, 类型为(AudioContextLatencyCategory 或 double),默认为"interactive"-

标识播放类型,这影响音频输出延迟和功耗之间的权衡。

latencyHint的首选值是来自AudioContextLatencyCategory的值。然而,也可以指定一个 double 值,表示延迟的秒数,以便更精细地控制延迟和功耗之间的平衡。浏览器可以自行决定如何适当解释该数值。实际使用的延迟由 AudioContext 的baseLatency属性给出。 sampleRate, 类型为 float-

为要创建的

AudioContext设置sampleRate。支持的值与AudioBuffer的采样率相同。如果指定的采样率不受支持,必须抛出NotSupportedError异常。如果未指定

sampleRate,则使用此AudioContext输出设备的首选采样率。 sinkId, 类型为(DOMString 或 AudioSinkOptions)-

音频输出设备的标识符或相关信息。有关更多详细信息,请参阅

sinkId。 renderSizeHint, 类型为(AudioContextRenderSizeCategory 或 unsigned long),默认为"default"-

这允许用户在传递整数时请求特定的 渲染量子大小,如果未指定或传递

"default",则使用默认的 128 帧;如果指定"hardware",则请求用户代理选择一个合适的 渲染量子大小。这只是一个可能不会被尊重的提示。

1.2.6. AudioSinkOptions

AudioSinkOptions

字典用于指定 sinkId

的选项。

dictionary AudioSinkOptions {required AudioSinkType type ; };

1.2.6.1. 字典 AudioSinkOptions

成员

type, 类型为 AudioSinkType-

值为

AudioSinkType,用于指定设备的类型。

1.2.7. AudioSinkInfo

AudioSinkInfo

接口用于通过 sinkId

获取当前音频输出设备的信息。

[Exposed =Window ]interface AudioSinkInfo {readonly attribute AudioSinkType type ; };

1.2.7.1. 属性

type, 类型为 AudioSinkType,只读-

表示设备类型的

AudioSinkType值。

1.2.8. AudioTimestamp

dictionary AudioTimestamp {double contextTime ;DOMHighResTimeStamp performanceTime ; };

1.2.8.1. 字典 AudioTimestamp

成员

contextTime, 类型为 double-

表示 BaseAudioContext 的

currentTime时间坐标系中的一个点。 performanceTime, 类型为 DOMHighResTimeStamp-

表示

Performance接口实现的时间坐标系中的一个点(描述于 [hr-time-3])。

1.2.9. AudioRenderCapacity

[Exposed =Window ]interface :AudioRenderCapacity EventTarget {undefined start (optional AudioRenderCapacityOptions = {});options undefined stop ();attribute EventHandler onupdate ; };

此接口提供 AudioContext

的渲染性能指标。为了计算这些指标,渲染器会在每次 系统级音频回调 中收集一个 负载值。

1.2.9.1. 属性

onupdate, 类型为 EventHandler-

此事件处理程序的事件类型是

update。派发到事件处理程序的事件将使用AudioRenderCapacityEvent接口。

1.2.9.2. 方法

start(options)-

开始收集和分析指标。这将会反复地触发一个事件,其名称为

update,并在AudioRenderCapacity上触发,使用AudioRenderCapacityEvent,其更新间隔由AudioRenderCapacityOptions指定。 stop()-

停止收集和分析指标。同时停止派发

update事件。

1.2.10.

AudioRenderCapacityOptions

AudioRenderCapacityOptions

词典用于为 AudioRenderCapacity

提供用户选项。

dictionary {AudioRenderCapacityOptions double updateInterval = 1; };

1.2.10.1. 词典 AudioRenderCapacityOptions

成员

updateInterval, 类型为 double,默认值为1-

用于调度

AudioRenderCapacityEvent的更新间隔(以秒为单位)。每个系统级音频回调都会计算一个 负载值,并且在指定的间隔期内会收集多个负载值。例如,如果渲染器的采样率为 48Khz,系统级音频回调的缓冲区大小为 192 帧,那么在 1 秒间隔内将会收集 250 个负载值。如果给定的值小于 系统级音频回调的持续时间,则会抛出

NotSupportedError。

1.2.11. AudioRenderCapacityEvent

[Exposed =Window ]interface :AudioRenderCapacityEvent Event {(constructor DOMString ,type optional AudioRenderCapacityEventInit = {});eventInitDict readonly attribute double timestamp ;readonly attribute double averageLoad ;readonly attribute double peakLoad ;readonly attribute double underrunRatio ; };dictionary :AudioRenderCapacityEventInit EventInit {double = 0;timestamp double = 0;averageLoad double = 0;peakLoad double = 0; };underrunRatio

1.2.11.1. 属性

timestamp, 类型为 double,只读-

数据收集周期的开始时间,基于关联的

AudioContext的currentTime。 averageLoad, 类型为 double,只读-

在给定的更新间隔中收集的负载值的平均值。精度限制为 1/100。

peakLoad, 类型为 double,只读-

在给定的更新间隔中收集的负载值的最大值。精度同样限制为 1/100。

underrunRatio, 类型为 double,只读-

在给定的更新间隔中,缓冲区欠载次数(当负载值大于 1.0 时)与系统级音频回调总数之间的比率。

设 \(u\) 为缓冲区欠载次数,\(N\) 为给定更新间隔中的系统级音频回调数,则缓冲区欠载比率为:

-

如果 \(u\) = 0,则比率为 0.0。

-

否则,计算 \(u/N\),并取最接近的 1/100 的向上取整值。

-

1.3. 接口 OfflineAudioContext

OfflineAudioContext

是 BaseAudioContext

的一种特殊类型,用于以比实时更快的速度进行渲染/混合。它不会直接渲染到音频硬件,而是尽可能快地渲染,并以 AudioBuffer

的形式返回渲染结果。

[Exposed =Window ]interface OfflineAudioContext :BaseAudioContext {constructor (OfflineAudioContextOptions contextOptions );constructor (unsigned long numberOfChannels ,unsigned long length ,float sampleRate );Promise <AudioBuffer >startRendering ();Promise <undefined >resume ();Promise <undefined >suspend (double );suspendTime readonly attribute unsigned long length ;attribute EventHandler oncomplete ; };

1.3.1. 构造函数

OfflineAudioContext(contextOptions)-

如果 当前设置对象的相关全局对象的关联文档不是完全活跃, 则抛出一个

令 c 为一个新的InvalidStateError并终止这些步骤。OfflineAudioContext对象。 初始化 c 如下:-

设置 c 的

[[控制线程状态]]为"suspended"。 -

设置 c 的

[[渲染线程状态]]为"suspended"。 -

根据

renderSizeHint的值确定此OfflineAudioContext的[[渲染量子大小]]:-

如果其值为默认值

"default"或"hardware", 则将[[渲染量子大小]]私有槽设置为 128。 -

否则,如果传入的是整数,用户代理可以选择是否尊重该值,并将其设置为

[[渲染量子大小]]私有槽。

-

-

构造一个

AudioDestinationNode, 其channelCount设置为contextOptions.numberOfChannels。 -

令 messageChannel 为一个新的

MessageChannel。 -

令 controlSidePort 为 messageChannel 的

port1属性的值。 -

令 renderingSidePort 为 messageChannel 的

port2属性的值。 -

令 serializedRenderingSidePort 为结构化序列化和传输(renderingSidePort, « renderingSidePort »)的结果。

-

将此

audioWorklet的port设置为 controlSidePort。 -

排队控制消息, 使用 serializedRenderingSidePort 设置 AudioContextGlobalScope 上的 MessagePort。

参数用于 OfflineAudioContext.constructor(contextOptions) 方法。 参数 类型 可为空 可选 描述 contextOptions构造此上下文所需的初始参数。 -

OfflineAudioContext(numberOfChannels, length, sampleRate)-

OfflineAudioContext可以使用与 AudioContext.createBuffer 相同的参数进行构造。如果任何参数为负数、零或超出其标称范围,则必须抛出NotSupportedError异常。OfflineAudioContext 的构造方式如下

new OfflineAudioContext({ numberOfChannels: numberOfChannels, length: length, sampleRate: sampleRate}) 相当于调用上述代码。

用于 OfflineAudioContext.constructor(numberOfChannels, length, sampleRate) 方法的参数。 参数 类型 可为空 可选 描述 numberOfChannelsunsigned long✘ ✘ 确定缓冲区将拥有的通道数。请参见 createBuffer()以了解支持的通道数。lengthunsigned long✘ ✘ 确定缓冲区的大小,以采样帧数计算。 sampleRatefloat✘ ✘ 描述缓冲区中线性 PCM 音频数据的采样率,以每秒采样帧数计算。请参见 createBuffer()以获取有效的采样率。

1.3.2. 属性

length, 类型为 unsigned long,只读-

缓冲区的大小,以采样帧数计算。这与构造函数的

length参数相同。 oncomplete, 类型为 EventHandler-

此事件处理程序的事件类型为

complete。分派到事件处理程序的事件将使用OfflineAudioCompletionEvent接口。它是OfflineAudioContext上触发的最后一个事件。

1.3.3. 方法

startRendering()-

根据当前的连接和计划的更改,开始渲染音频。

虽然获取渲染的音频数据的主要方式是通过其返回的 promise,但实例也会因为兼容原因触发一个名为

complete的事件。让[[rendering started]]成为这个OfflineAudioContext的一个内部槽。 初始化这个槽为 false。当调用

startRendering时,以下步骤必须在 控制线程 上执行:- 如果 this 的 相关全局对象 的 关联文档不是 完全激活,则返回 一个被拒绝的 promise,值为 "

InvalidStateError"DOMException。 - 如果

[[rendering started]]槽上的OfflineAudioContext为 true,返回一个被拒绝的 promise,值为InvalidStateError, 并中止这些步骤。 - 将

[[rendering started]]槽设置为 true。 - 创建一个新的 promise,赋值给 promise。

- 创建一个新的

AudioBuffer, 其通道数、长度和采样率分别等于传递给此实例构造函数的contextOptions参数中的numberOfChannels、length和sampleRate的值。 将此缓冲区分配给OfflineAudioContext的一个内部槽[[rendered buffer]]。 - 如果在调用上述

AudioBuffer构造函数期间抛出异常,使用该异常拒绝 promise。 - 否则,如果缓冲区成功构建,开始离线渲染。

- 将 promise 添加到

[[pending promises]]。 - 返回 promise。

要 开始离线渲染,必须在为此创建的 渲染线程 上执行以下步骤:- 根据当前的连接和计划的更改,开始将

length个采样帧的音频渲染到[[rendered buffer]]中。 - 对于每个 渲染量子,检查并

暂停渲染(如有必要)。 - 如果已暂停的上下文被恢复,则继续渲染缓冲区。

- 渲染完成后,队列媒体元素任务以执行以下步骤:

- 使用

[[rendered buffer]]来解决由startRendering()创建的 promise。 - 队列媒体元素任务 以 触发一个名为

complete的事件, 在OfflineAudioContext上, 使用OfflineAudioCompletionEvent, 其renderedBuffer属性设置为[[rendered buffer]]。

- 使用

无参数。返回类型:Promise<AudioBuffer> - 如果 this 的 相关全局对象 的 关联文档不是 完全激活,则返回 一个被拒绝的 promise,值为 "

resume()-

恢复

OfflineAudioContext的currentTime的进度,当其已被暂停时。当调用 resume 时,执行以下步骤:-

如果 this 的 相关全局对象 的 关联文档 不是 完全激活,则返回 一个被拒绝的 promise,值为 "

InvalidStateError"DOMException。 -

创建一个新的 Promise,赋值给 promise。

-

如果以下任意条件为真,则中止这些步骤并使用

InvalidStateError拒绝 promise:-

[[control thread state]]在OfflineAudioContext上的值为closed。 -

[[rendering started]]槽在OfflineAudioContext上的值为 false。

-

-

将

[[control thread state]]标志设置为running,针对OfflineAudioContext。 -

返回 promise。

运行一个 控制消息 来恢复OfflineAudioContext表示在为此创建的 渲染线程 上执行这些步骤:-

将

[[rendering thread state]]在OfflineAudioContext上设置为running。 -

开始 渲染音频图。

-

如果失败,队列媒体元素任务 以拒绝 promise 并中止剩余的步骤。

-

队列媒体元素任务 以执行以下步骤:

-

解决 promise。

-

如果

state属性在OfflineAudioContext中还不是 "running":-

将

state属性在OfflineAudioContext设置为 "running"。 -

队列媒体元素任务 以 触发一个名为

statechange的事件,在OfflineAudioContext。

-

-

无参数。 -

suspend(suspendTime)-

在指定的时间安排音频上下文的时间进度暂停,并返回一个 promise。这通常用于在

OfflineAudioContext上同步操作音频图时使用。注意,暂停的最大精度为 渲染量子 的大小, 并且指定的暂停时间将向上舍入到最近的 渲染量子 边界。 因此,不允许在同一个量化帧安排多个暂停。此外,应在上下文未运行时进行安排,以确保精确的暂停。

OfflineAudioContext.suspend() 方法的参数OfflineAudioContext.suspend()。 参数 类型 可为空 可选 描述 suspendTimedouble✘ ✘ 在指定的时间安排渲染的暂停,该时间被量化并向上舍入到 渲染量子 大小。如果量化后的帧号 - 为负或

- 小于或等于当前时间或

- 大于或等于总渲染持续时间或

- 由另一个暂停安排在相同的时间,

InvalidStateError拒绝。

1.3.4. OfflineAudioContextOptions

此选项用于构建 OfflineAudioContext

时指定使用的选项。

dictionary OfflineAudioContextOptions {unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; (AudioContextRenderSizeCategory or unsigned long )renderSizeHint = "default"; };

1.3.4.1. Dictionary OfflineAudioContextOptions

成员

length, 类型为 unsigned long-

渲染的

AudioBuffer的长度,以采样帧(sample-frames)为单位。 numberOfChannels, 类型为 unsigned long,默认值为1-

此

OfflineAudioContext的声道数量。 sampleRate, 类型为 float-

此

OfflineAudioContext的采样率。 renderSizeHint, 类型为(AudioContextRenderSizeCategory 或 unsigned long),默认值为"default"-

此

OfflineAudioContext的 渲染量子大小 的提示。

1.3.5.

The OfflineAudioCompletionEvent

接口

这是一个 Event

对象,由于兼容性原因被派发给 OfflineAudioContext。

[Exposed =Window ]interface OfflineAudioCompletionEvent :Event {(constructor DOMString ,type OfflineAudioCompletionEventInit );eventInitDict readonly attribute AudioBuffer renderedBuffer ; };

1.3.5.1. 属性

renderedBuffer, 类型为 AudioBuffer, 只读-

包含已渲染音频数据的

AudioBuffer。

1.3.5.2.

OfflineAudioCompletionEventInit

dictionary OfflineAudioCompletionEventInit :EventInit {required AudioBuffer renderedBuffer ; };

1.3.5.2.1. 字典 OfflineAudioCompletionEventInit

成员

renderedBuffer, 类型为 AudioBuffer-

要分配给事件的

renderedBuffer属性的值。

1.4. The AudioBuffer

接口

此接口表示一个存储在内存中的音频资源。它可以包含一个或多个声道,每个声道的内容为 32 位浮点线性 PCM值,标称范围为 \([-1,1]\),但数值并不局限于此范围。通常,PCM

数据的长度预期较短(通常小于一分钟)。对于更长的声音,如音乐原声,应当使用

audio

元素和 MediaElementAudioSourceNode

进行流式传输。

一个 AudioBuffer

可以被一个或多个 AudioContext

使用,并且可以在 OfflineAudioContext

和 AudioContext

之间共享。

AudioBuffer

有四个内部槽位:

[[number of channels]]-

此

AudioBuffer的音频声道数量,是一个无符号长整数。 [[length]]-

此

AudioBuffer每个声道的长度,是一个无符号长整数。 [[sample rate]]-

此

AudioBuffer的采样率,以 Hz 为单位,是一个浮点数。 [[internal data]]-

一个包含音频样本数据的 数据块。

[Exposed =Window ]interface AudioBuffer {constructor (AudioBufferOptions );options readonly attribute float sampleRate ;readonly attribute unsigned long length ;readonly attribute double duration ;readonly attribute unsigned long numberOfChannels ;Float32Array getChannelData (unsigned long );channel undefined copyFromChannel (Float32Array ,destination unsigned long ,channelNumber optional unsigned long = 0);bufferOffset undefined copyToChannel (Float32Array ,source unsigned long ,channelNumber optional unsigned long = 0); };bufferOffset

1.4.1. 构造函数

AudioBuffer(options)-

-

如果

options中的任何值超出其标称范围,则抛出NotSupportedError异常,并中止以下步骤。 -

让 b 成为一个新的

AudioBuffer对象。 -

分别将构造函数中传入的

AudioBufferOptions的属性numberOfChannels、length、sampleRate的值分别分配给内部槽位[[number of channels]]、[[length]]、[[sample rate]]。 -

将此

AudioBuffer的内部槽位[[internal data]]设置为调用CreateByteDataBlock的结果(。[[length]]*[[number of channels]])注意:这将把底层存储初始化为零。

-

返回 b。

参数列表 AudioBuffer.constructor() 方法。 参数 类型 可为 null 可选 描述 optionsAudioBufferOptions✘ ✘ 一个 AudioBufferOptions,用于确定此AudioBuffer的属性。 -

1.4.2. 属性

duration, 类型为 double,只读-

PCM 音频数据的时长,单位为秒。

该值通过

[[sample rate]]和[[length]]计算得出,计算方法是将[[length]]除以[[sample rate]]。 length, 类型为 unsigned long,只读-

PCM 音频数据的长度,单位为采样帧。这必须返回

[[length]]的值。 numberOfChannels, 类型为 unsigned long,只读-

离散音频通道的数量。这必须返回

[[number of channels]]的值。 sampleRate, 类型为 float,只读-

PCM 音频数据的采样率,单位为每秒采样数。这必须返回

[[sample rate]]的值。

1.4.3. 方法

copyFromChannel(destination, channelNumber, bufferOffset)-

copyFromChannel()方法从AudioBuffer指定通道中复制样本到destination数组。设

buffer为AudioBuffer,具有 \(N_b\) 帧,设 \(N_f\) 为destination数组的元素个数,\(k\) 为bufferOffset的值。然后从buffer复制到destination的帧数为 \(\max(0, \min(N_b - k, N_f))\)。如果此值小于 \(N_f\),则剩余的destination元素将不会被修改。参数 AudioBuffer.copyFromChannel() 方法。 参数 类型 可为空 可选 描述 destinationFloat32Array✘ ✘ 要复制通道数据的数组。 channelNumberunsigned long✘ ✘ 要从中复制数据的通道索引。如果 channelNumber大于等于AudioBuffer的通道数量,必须抛出IndexSizeError。bufferOffsetunsigned long✘ ✔ 可选的偏移量,默认为 0。从此偏移量开始从 AudioBuffer中复制数据到destination。返回类型:undefined copyToChannel(source, channelNumber, bufferOffset)-

copyToChannel()方法从source数组中复制样本到AudioBuffer指定通道。如果

source无法复制到缓冲区,可能抛出UnknownError。设

buffer为AudioBuffer,具有 \(N_b\) 帧,设 \(N_f\) 为source数组的元素个数,\(k\) 为bufferOffset的值。然后从source复制到buffer的帧数为 \(\max(0, \min(N_b - k, N_f))\)。如果此值小于 \(N_f\),则buffer中的剩余元素将不会被修改。参数 AudioBuffer.copyToChannel() 方法。 参数 类型 可为空 可选 描述 sourceFloat32Array✘ ✘ 从中复制通道数据的数组。 channelNumberunsigned long✘ ✘ 要复制数据的通道索引。如果 channelNumber大于等于AudioBuffer的通道数量,必须抛出IndexSizeError。bufferOffsetunsigned long✘ ✔ 可选的偏移量,默认为 0。从此偏移量开始将 source数据复制到AudioBuffer。返回类型:undefined getChannelData(channel)-

根据 获取内容 的规则,允许要么对

[[internal data]]进行写入,要么获取存储在该内部数据块中的字节副本,并创建一个新的Float32Array。如果

[[internal data]]或新创建的Float32Array无法被创建,可能抛出UnknownError。参数 AudioBuffer.getChannelData() 方法。 参数 类型 可为空 可选 描述 channelunsigned long✘ ✘ 表示要获取数据的特定通道的索引。索引值为 0 表示第一个通道。此索引值必须小于 [[number of channels]],否则必须抛出IndexSizeError异常。返回类型:Float32Array

注意: 方法 copyToChannel()

和 copyFromChannel()

可以通过传入 Float32Array

作为较大数组的视图,来填充数组的一部分。当从 AudioBuffer

的通道读取数据并以块形式处理数据时,应优先使用 copyFromChannel(),而不是调用

getChannelData()

并访问结果数组,因为这样可以避免不必要的内存分配和复制。

当某些 API 实现需要使用 AudioBuffer

的内容时,会调用内部操作 获取 AudioBuffer

的内容。该操作会向调用方返回不可变的通道数据。

AudioBuffer

进行 获取内容 操作时,执行以下步骤:

-

如果

AudioBuffer的任何ArrayBuffer被 分离,返回true,中止这些步骤,并向调用方返回一个零长度的通道数据缓冲区。 -

分离 由此

AudioBuffer上的getChannelData()方法之前返回的所有ArrayBuffer。注意:由于

AudioBuffer只能通过createBuffer()或AudioBuffer构造函数创建,因此这不会抛出异常。 -

保留这些

ArrayBuffer的[[internal data]]底层数据,并将它们的引用返回给调用方。 -

将包含数据副本的

ArrayBuffer附加到AudioBuffer,以便在下次调用getChannelData()时返回。

在以下情况下会调用 获取 AudioBuffer 内容 操作:

-

当调用

AudioBufferSourceNode.start时,会 获取节点的buffer的内容。如果操作失败,则不会播放任何内容。 -

当

buffer被设置给一个AudioBufferSourceNode且之前已经调用了AudioBufferSourceNode.start,则设置器会 获取AudioBuffer的内容。如果操作失败,则不会播放任何内容。 -

当

ConvolverNode的buffer设置为AudioBuffer时,它会 获取AudioBuffer的内容。 -

当

AudioProcessingEvent的分派完成时,它会 获取 其outputBuffer的内容。

注意: 这意味着 copyToChannel()

不能用于更改目前被 AudioNode 使用的

AudioBuffer

的内容,因为该 AudioNode 已经

获取了该 AudioBuffer

的内容,并将继续使用之前获取的数据。

1.4.4.

AudioBufferOptions

此部分指定用于构造 AudioBuffer

的选项。

length

和

sampleRate

成员是必需的。

dictionary AudioBufferOptions {unsigned long numberOfChannels = 1;required unsigned long length ;required float sampleRate ; };

1.4.4.1.

Dictionary

AudioBufferOptions

Members

该字典成员的允许值是有约束的。请参见

createBuffer()

。

-

length, 类型为 unsigned long -

缓冲区的采样帧长度。请参见

length了解约束。 -

numberOfChannels, 类型为 unsigned long ,默认值为1 -

缓冲区的通道数。请参见

numberOfChannels了解约束。 -

sampleRate, 类型为 float -

缓冲区的采样率,单位为 Hz。请参见

sampleRate了解约束。

1.5. The AudioNode

Interface

AudioNode 是

AudioContext

的构建模块。

该接口表示音频源、音频目标和中间处理模块。这些模块可以相互连接以形成用于将音频渲染到音频硬件的 处理图。

每个节点可以有 输入 和/或 输出。一个 源节点 没有输入且只有一个输出。

大多数处理节点,如滤波器,将有一个输入和一个输出。每种类型的 AudioNode 在其处理或合成音频的细节上有所不同。

但通常情况下,一个 AudioNode

会处理其输入(如果有)并为其输出(如果有)生成音频。

每个输出有一个或多个通道。确切的通道数取决于具体的 AudioNode 的详细信息。

一个输出可以连接到一个或多个 AudioNode 的输入,从而支持 扇出。一个输入最初没有连接,但可以从一个或多个 AudioNode

的输出连接,从而支持 扇入。

当调用 connect() 方法将一个 AudioNode 的输出连接到另一个 AudioNode 的输入时,我们称之为对该输入的

连接。

每个 AudioNode

的 输入 在任何给定时间都有特定数量的通道。

这个数量可能会根据对该输入进行的 连接 而发生变化。

如果该输入没有连接,则它有一个静音的通道。

对于每个 输入,一个 AudioNode 对所有连接到该输入的连接执行混合操作。

请参见 § 4 通道上混和下混 获取规范要求和详细信息。

输入的处理和 AudioNode

的内部操作在

AudioContext

时间上持续进行,

无论节点是否有连接的输出,也无论这些输出是否最终到达 AudioContext 的 AudioDestinationNode。

[Exposed =Window ]interface AudioNode :EventTarget {AudioNode connect (AudioNode destinationNode ,optional unsigned long output = 0,optional unsigned long input = 0);undefined connect (AudioParam destinationParam ,optional unsigned long output = 0);undefined disconnect ();undefined disconnect (unsigned long output );undefined disconnect (AudioNode destinationNode );undefined disconnect (AudioNode destinationNode ,unsigned long output );undefined disconnect (AudioNode destinationNode ,unsigned long output ,unsigned long input );undefined disconnect (AudioParam destinationParam );undefined disconnect (AudioParam destinationParam ,unsigned long output );readonly attribute BaseAudioContext context ;readonly attribute unsigned long numberOfInputs ;readonly attribute unsigned long numberOfOutputs ;attribute unsigned long channelCount ;attribute ChannelCountMode channelCountMode ;attribute ChannelInterpretation channelInterpretation ; };

1.5.1. AudioNode 创建

AudioNode

可以通过两种方式创建:一种是使用该特定接口的构造函数,另一种是使用

BaseAudioContext

或

AudioContext

上的

工厂方法。

作为 AudioNode

构造函数第一个参数传递的

BaseAudioContext,

被称为要创建的 AudioNode 的

关联的 BaseAudioContext。

类似地,当使用工厂方法时,关联的

BaseAudioContext 是调用该工厂方法的

BaseAudioContext。

BaseAudioContext c 上创建一个特定类型 n 的新

AudioNode,执行以下步骤:

-

让 node 成为一个新对象,类型为 n。

-

让 option 成为与该工厂方法关联的接口 关联的字典类型。

-

对于传递给工厂方法的每个参数,将 option 中同名的字典成员设置为该参数的值。

-

使用 c 和 option 作为参数在 node 上调用 n 的构造函数。

-

返回 node

AudioNode

的对象 o,

意味着执行以下步骤,给定传递给此接口构造函数的参数 context 和 dict。

-

将 o 的关联

BaseAudioContext设置为 context。 -

将其值为

numberOfInputs,numberOfOutputs,channelCount,channelCountMode,channelInterpretation设置为此特定接口在每个AudioNode部分中概述的默认值。 -

对于传入的 dict 的每个成员,执行以下步骤,k 为成员的键,v 为其值。 如果在执行这些步骤时抛出任何异常,终止迭代并将异常传播给算法(构造函数或工厂方法)的调用者。

-

如果 k 是此接口上

AudioParam的名称, 则将此AudioParam的value属性设置为 v。 -

否则,如果 k 是此接口上的属性名称,则将与此属性关联的对象设置为 v。

-

工厂方法的关联接口是从此方法返回的对象的接口。 接口的关联选项对象是可以传递给该接口构造函数的选项对象。

AudioNode 是

EventTarget,

如 [DOM] 所述。这意味着可以向

AudioNode

派发事件,

就像其他 EventTarget

接受事件一样。

enum {ChannelCountMode "max" ,"clamped-max" ,"explicit" };

ChannelCountMode,

与节点的 channelCount

和 channelInterpretation

值结合使用,

用于确定控制如何混合输入到节点的计算出的通道数。

计算出的通道数如下所示。

有关混音的更多信息,请参阅§ 4 通道上混合和下混合。

| 枚举值 | 描述 |

|---|---|

"max" |

计算出的通道数是输入的所有连接通道数中的最大值。在这种模式下,

channelCount

被忽略。

|

"clamped-max" |

计算出的通道数的确定方式与

"max"

相同,然后将其限制为给定的最大值

channelCount。

|

"explicit" |

计算出的通道数是

channelCount

指定的确切值。

|

enum {ChannelInterpretation "speakers" ,"discrete" };

| 枚举值 | 描述 |

|---|---|

"speakers" |

使用 上混合公式 或 下混合公式。当通道数量不匹配任何这些基本扬声器布局时,恢复为

"discrete"。

|

"discrete" |

通过填充通道直到用完来上混合,然后将剩余的通道置为零。通过填充尽可能多的通道来下混合,然后丢弃剩余的通道。 |

1.5.2. AudioNode 尾时间

一个 AudioNode

可以具有尾时间。

这意味着即使 AudioNode

输入为静音,其输出也可能是非静音的。

AudioNode

如果具有内部处理状态,

即过去的输入会影响未来的输出,则具有非零的尾时间。即使输入从非静音过渡到静音,这些 AudioNode

也可能在计算的尾时间内继续产生非静音的输出。

1.5.3. AudioNode 生命周期

一个 AudioNode

在 渲染量子期间可能是主动处理的,如果以下条件中的任何一个成立。

-

如果且仅当

AudioScheduledSourceNode在当前渲染量子的某部分时间内播放时,它是主动处理的。 -

如果且仅当

MediaElementAudioSourceNode的mediaElement在当前渲染量子的某部分时间内正在播放,它是主动处理的。 -

当与

MediaStreamTrack关联的MediaStreamAudioSourceNode或MediaStreamTrackAudioSourceNode的readyState属性等于"live",muted属性等于false且enabled属性等于true时,它们是主动处理的。 -

当

DelayNode在一个循环中时, 只有当当前 渲染量子 中的任何输出样本的绝对值大于或等于 \( 2^{-126} \) 时,它是主动处理的。 -

当

ScriptProcessorNode的输入或输出已连接时,它是主动处理的。 -

当

AudioWorkletNode的AudioWorkletProcessor的[[callable process]]返回true,且它的 活动源标志为true或连接到其输入之一的任何AudioNode是主动处理的。 -

其他所有

AudioNode在连接到其输入之一的任何AudioNode是主动处理时开始主动处理, 当接收来自其他主动处理AudioNode的输入不再影响输出时,停止主动处理。

1.5.4. 属性

channelCount,类型为 无符号长整型-

channelCount是用于上混和下混连接到节点的任何输入的通道数量。默认值是2,除了一些特定节点的值是特别确定的。对于没有输入的节点,此属性没有效果。如果此值设置为零或超过实现的最大通道数量,实施必须抛出NotSupportedError异常。此外,一些节点对通道数量的可能值具有额外的channelCount 约束:

AudioDestinationNode-

行为取决于目标节点是否是

AudioContext或OfflineAudioContext的目标:AudioContext-

通道数量必须在 1 到

maxChannelCount之间。任何试图将通道数量设置在此范围之外的操作必须抛出IndexSizeError异常。 OfflineAudioContext-

通道数量不能更改。任何试图更改此值的操作必须抛出

InvalidStateError异常。

AudioWorkletNodeChannelMergerNode-

通道数量不可更改,任何试图更改此值的操作必须抛出

InvalidStateError异常。 ChannelSplitterNode-

通道数量不可更改,任何试图更改此值的操作必须抛出

InvalidStateError异常。 ConvolverNode-

通道数量不能大于 2,任何试图将其更改为大于 2 的值的操作必须抛出

NotSupportedError异常。 DynamicsCompressorNode-

通道数量不能大于 2,任何试图将其更改为大于 2 的值的操作必须抛出

NotSupportedError异常。 PannerNode-

通道数量不能大于 2,任何试图将其更改为大于 2 的值的操作必须抛出

NotSupportedError异常。 ScriptProcessorNode-

通道数量不可更改,任何试图更改此值的操作必须抛出

NotSupportedError异常。 StereoPannerNode-

通道数量不能大于 2,任何试图将其更改为大于 2 的值的操作必须抛出

NotSupportedError异常。

有关此属性的更多信息,请参阅 § 4 通道上混和下混。

channelCountMode,类型为 ChannelCountMode-

channelCountMode决定在上混和下混连接到节点的任何输入时如何计算通道数量。默认值为 "max"。 对于没有输入的节点,此属性没有效果。此外,一些节点对通道数量模式的可能值具有额外的 channelCountMode 约束:

AudioDestinationNode-

如果

AudioDestinationNode是目标节点的OfflineAudioContext, 则通道数量模式不能更改。任何试图更改此值的操作必须抛出InvalidStateError异常。 ChannelMergerNode-

通道数量模式不能从 "

explicit" 更改,任何试图更改此值的操作必须抛出InvalidStateError异常。 ChannelSplitterNode-

通道数量模式不能从 "

explicit" 更改,任何试图更改此值的操作必须抛出InvalidStateError异常。 ConvolverNode-

通道数量模式不能设置为 "

max", 任何试图将其设置为 "max" 的操作必须抛出NotSupportedError异常。 DynamicsCompressorNode-

通道数量模式不能设置为 "

max", 任何试图将其设置为 "max" 的操作必须抛出NotSupportedError异常。 PannerNode-

通道数量模式不能设置为 "

max", 任何试图将其设置为 "max" 的操作必须抛出NotSupportedError异常。 ScriptProcessorNode-

通道数量模式不能从 "

explicit" 更改,任何试图更改此值的操作必须抛出NotSupportedError异常。 StereoPannerNode-

通道数量模式不能设置为 "

max", 任何试图将其设置为 "max" 的操作必须抛出NotSupportedError异常。

有关此属性的更多信息,请参阅 § 4 通道上混和下混部分。

channelInterpretation,类型为 ChannelInterpretation-

channelInterpretation决定在将连接上混或下混到节点的输入时如何处理各个通道。默认值为 "speakers"。 对于没有输入的节点,此属性没有效果。此外,一些节点对通道解释的可能值有额外的 channelInterpretation 约束:

ChannelSplitterNode-

通道解释不能从 "

discrete" 更改,任何试图更改此值的操作必须抛出InvalidStateError异常。

有关此属性的更多信息,请参阅 § 4 通道上混和下混。

context,类型为 BaseAudioContext,只读-

拥有此

AudioNode的BaseAudioContext。 numberOfInputs,类型为 无符号长整型,只读-

传入

AudioNode的输入数量。对于 源节点,此值为 0。对于许多AudioNode类型,此属性是预定的,但对于某些AudioNode, 如ChannelMergerNode和AudioWorkletNode, 输入数量是可变的。 numberOfOutputs,类型为 无符号长整型,只读-

从

AudioNode输出的数量。对于某些AudioNode类型,此属性是预定的,但对于某些节点类型,如ChannelSplitterNode和AudioWorkletNode, 输出数量是可变的。

1.5.5. 方法

connect(destinationNode, output, input)-

在特定节点的给定输出和另一个特定节点的给定输入之间只能有一个连接。具有相同终点的多个连接将被忽略。

此方法返回

destinationAudioNode对象。AudioNode.connect(destinationNode, output, input) 方法的参数。 参数 类型 可为 null 可选 描述 destinationNodedestination参数是要连接的AudioNode。如果destination参数是一个来自另一个AudioNode,并且该AudioContext已被创建,那么必须抛出一个InvalidAccessError。 也就是说,AudioNodes 不能在多个AudioContexts 之间共享。多个AudioNodes 可以连接到同一个AudioNode, 这在 频道上行混合和下行混合 部分有描述。output无符号长整型✘ ✔ output参数是一个索引,用于描述要从中连接的AudioNode的哪个输出。如果该参数超出边界,必须抛出IndexSizeError异常。 可以通过多次调用 connect() 将一个AudioNode输出连接到多个输入,从而支持“扇出”。inputinput参数是一个索引,用于描述要连接到的目标AudioNode的哪个输入。如果该参数超出边界,必须抛出IndexSizeError异常。 可以将一个AudioNode连接到另一个AudioNode的输入或AudioParam, 从而形成循环。返回类型:AudioNode connect(destinationParam, output)-

将

AudioNode连接到AudioParam, 通过 a-rate 信号控制参数值。可以通过多次调用 connect() 将

AudioNode输出连接到多个AudioParam, 从而支持“扇出”。可以通过多次调用 connect() 将多个

AudioNode输出连接到一个AudioParam, 从而支持“扇入”。AudioParam将从连接到它的任何AudioNode输出中获取渲染的音频数据,并将其 转换为单声道,如果它不是单声道,则通过下混合,然后与其他这些输出混合在一起,最后与固有参数值(即在没有任何音频连接的情况下,AudioParam通常具有的value值)一起混合,包括为该参数安排的任何时间线更改。将音频数据下混为单声道的过程等效于

AudioNode的下混,前提是channelCount= 1,channelCountMode= "explicit", 并且channelInterpretation= "speakers"。在特定节点的给定输出和特定的

AudioParam之间只能有一个连接。具有相同终点的多个连接将被忽略。AudioNode.connect(destinationParam, output) 方法的参数。 参数 类型 可为 null 可选 描述 destinationParamAudioParam✘ ✘ destination参数是要连接的AudioParam。 此方法不返回destinationAudioParam对象。如果destinationParam属于一个AudioNode, 而该BaseAudioContext与创建此方法调用的BaseAudioContext不同,则必须抛出InvalidAccessError异常。output无符号长整型✘ ✔ output参数是一个索引,用于描述要从中连接的AudioNode的哪个输出。如果parameter参数超出边界,则必须抛出IndexSizeError异常。返回类型:undefined disconnect()-

断开来自

AudioNode的所有输出连接。无参数。返回类型:undefined disconnect(output)-

断开

AudioNode的单个输出与任何其他AudioNode或AudioParam对象的连接。AudioNode.disconnect(output) 方法的参数。 参数 类型 可为 null 可选 描述 output无符号长整型✘ ✘ 此参数是一个索引,用于描述要断开的 AudioNode的哪个输出。它将断开给定输出的所有连接。如果此参数超出边界,则必须抛出IndexSizeError异常。返回类型:undefined disconnect(destinationNode)-

断开

AudioNode的所有输出与指定目标AudioNode的连接。AudioNode.disconnect(destinationNode) 方法的参数。 参数 类型 可为 null 可选 描述 destinationNodedestinationNode参数是要断开的AudioNode。 它将断开到给定destinationNode的所有输出连接。如果没有到destinationNode的连接,则必须抛出InvalidAccessError异常。返回类型:undefined disconnect(destinationNode, output)-

断开

AudioNode的特定输出与某个目标AudioNode的所有输入的连接。AudioNode.disconnect(destinationNode, output) 方法的参数。 参数 类型 可为 null 可选 描述 destinationNodedestinationNode参数是要断开的AudioNode。 如果给定输出没有连接到destinationNode,则必须抛出InvalidAccessError异常。output无符号长整型✘ ✘ output参数是一个索引,用于描述要断开的AudioNode的哪个输出。如果此参数超出边界,则必须抛出IndexSizeError异常。返回类型:undefined disconnect(destinationNode, output, input)-

断开

AudioNode的特定输出与某个目标AudioNode的特定输入的连接。AudioNode.disconnect(destinationNode, output, input) 方法的参数。 参数 类型 可为 null 可选 描述 destinationNodedestinationNode参数是要断开的AudioNode。 如果给定输出到给定输入没有连接到destinationNode,则必须抛出InvalidAccessError异常。output无符号长整型✘ ✘ output参数是一个索引,用于描述要断开的AudioNode的哪个输出。如果此参数超出边界,则必须抛出IndexSizeError异常。inputinput参数是一个索引,用于描述目标AudioNode的哪个输入要断开。如果此参数超出边界,则必须抛出IndexSizeError异常。返回类型:undefined disconnect(destinationParam)-

断开

AudioNode的所有输出与特定目标AudioParam的连接。当此操作生效时,该AudioNode对计算出的参数值的贡献变为 0。本征参数值不受此操作的影响。AudioNode.disconnect(destinationParam) 方法的参数。 参数 类型 可为 null 可选 描述 destinationParamAudioParam✘ ✘ destinationParam参数是要断开的AudioParam。 如果没有到destinationParam的连接,则必须抛出InvalidAccessError异常。返回类型:undefined disconnect(destinationParam, output)-

断开

AudioNode的特定输出与某个目标AudioParam的连接。当此操作生效时,该AudioNode对计算出的参数值的贡献变为 0。本征参数值不受此操作的影响。AudioNode.disconnect(destinationParam, output) 方法的参数。 参数 类型 可为 null 可选 描述 destinationParamAudioParam✘ ✘ destinationParam参数是要断开的AudioParam。 如果没有到destinationParam的连接,则必须抛出InvalidAccessError异常。output无符号长整型✘ ✘ output参数是一个索引,用于描述要断开的AudioNode的哪个输出。如果该参数超出边界,则必须抛出IndexSizeError异常。返回类型:undefined

1.5.6.

AudioNodeOptions

此项指定了构建所有 AudioNode

的选项。所有成员都是可选的。然而,实际节点使用的具体值取决于每个节点的实际情况。

dictionary AudioNodeOptions {unsigned long channelCount ;ChannelCountMode channelCountMode ;ChannelInterpretation channelInterpretation ; };

1.5.6.1. 字典 AudioNodeOptions

成员

channelCount, 类型为 unsigned long-

所需的

channelCount属性的通道数量。 channelCountMode, 类型为 ChannelCountMode-

所需的

channelCountMode属性的模式。 channelInterpretation, 类型为 ChannelInterpretation-

所需的

channelInterpretation属性的模式。

1.6. AudioParam

接口

AudioParam

控制单个 AudioNode 功能的

方面,如音量。可以使用 value 属性立即将参数设置为特定值。或者,可以安排值的更改,

这些更改将在非常精确的时间发生(在 AudioContext

的 currentTime

属性的坐标系统中),用于包络、音量渐变、低频振荡器(LFO)、滤波器扫描、粒子窗等。通过这种方式,

可以在任何 AudioParam

上设置

任意的基于时间轴的自动化曲线。此外,来自 AudioNode

输出的音频信号

可以连接到 AudioParam,

与 固有 参数值相加。

一些合成和处理的 AudioNode

具有作为属性的 AudioParam,

其值必须考虑每个音频样本。对于其他 AudioParam,

样本精度不重要,可以更粗略地采样值的变化。每个单独的 AudioParam

会指定它是一个 a-rate 参数,这意味着它的值

必须在每个音频样本的基础上考虑,或者它是一个 k-rate 参数。

实现必须使用块处理,每个 AudioNode

处理一个 渲染量子。

对于每个 渲染量子,k-rate

参数的值必须在第一个样本帧的时间进行采样,并且该值必须用于整个块。a-rate 参数必须为该块的每个样本帧进行采样。

根据 AudioParam,

可以通过设置 automationRate

属性为 "a-rate"

或 "k-rate"

来控制其速率。

详细信息请参阅每个 AudioParam

的描述。

每个 AudioParam

包含 minValue

和 maxValue

属性,这两个属性共同形成参数的 简单名义范围。

实际上,参数的值被限制在 \([\mathrm{minValue}, \mathrm{maxValue}]\) 范围内。详细信息请参见 § 1.6.3

值的计算。

对于许多 AudioParam,

minValue

和 maxValue

应设置为最大可能范围。在这种情况下,maxValue

应设置为 最正单精度浮动

值,即 3.4028235e38。(然而,在仅支持 IEEE-754 双精度浮动值的 JavaScript 中,必须写成 3.4028234663852886e38。)

同样,minValue

应设置为 最负单精度浮动 值,

即最正单精度浮动值的负数:-3.4028235e38。(在 JavaScript 中,这应写成 -3.4028234663852886e38。)

一个 AudioParam

保持一个零个或多个 自动化事件

的列表。每个自动化事件

指定在特定时间范围内对参数值的变化,基于其 自动化事件时间,

在 AudioContext

的

currentTime

属性的时间坐标系统中。自动化事件的列表按自动化事件时间的升序排列。

给定自动化事件的行为是 AudioContext

当前时间的函数,

以及该事件和列表中相邻事件的自动化事件时间。以下 自动化方法

通过向事件列表中添加一个新的事件来改变事件列表,该事件的类型特定于该方法:

-

setValueAtTime()-设置值 -

linearRampToValueAtTime()-线性渐变到值 -

exponentialRampToValueAtTime()-指数渐变到值 -

setTargetAtTime()-设置目标 -

setValueCurveAtTime()-设置值曲线

调用这些方法时将适用以下规则:

-

自动化事件时间 不会根据当前的采样率进行量化。计算曲线和渐变的公式会应用于调度事件时给定的精确数值时间。

-

如果在已经有一个或多个事件的时间点添加了这些事件,它将被放置在它们之后,但在事件时间点之后的事件之前。

-

如果在时间 \(T\) 和持续时间 \(D\) 调用 setValueCurveAtTime(),并且有任何事件的时间严格大于 \(T\), 但严格小于 \(T + D\),则必须抛出

NotSupportedError异常。 换句话说,在包含其他事件的时间段内调度值曲线是不允许的,但可以在其他事件的时间点精确调度值曲线。 -

类似地,如果在时间区间 \([T, T+D)\) 内的任何时间调用了任何 自动化方法,其中 \(T\) 是曲线的时间,\(D\) 是其持续时间,则必须抛出

NotSupportedError异常。

注意: AudioParam

属性是只读的,除了 value

属性外。

可以通过设置 automationRate

属性来选择 AudioParam

的自动化速率,

该属性可以有以下值。然而,一些 AudioParam

有一些关于是否可以更改自动化速率的限制。

enum {AutomationRate "a-rate" ,"k-rate" };

| 枚举值 | 描述 |

|---|---|

"a-rate"

| 该 AudioParam

被设置为 a-rate

处理。

|

"k-rate"

| 该 AudioParam

被设置为 k-rate

处理。

|

每个 AudioParam

都有一个内部槽 [[current value]],

初始设置为该 AudioParam 的

defaultValue。

[Exposed =Window ]interface AudioParam {attribute float value ;attribute AutomationRate automationRate ;readonly attribute float defaultValue ;readonly attribute float minValue ;readonly attribute float maxValue ;AudioParam setValueAtTime (float ,value double );startTime AudioParam linearRampToValueAtTime (float ,value double );endTime AudioParam exponentialRampToValueAtTime (float ,value double );endTime AudioParam setTargetAtTime (float ,target double ,startTime float );timeConstant AudioParam setValueCurveAtTime (sequence <float >,values double ,startTime double );duration AudioParam cancelScheduledValues (double );cancelTime AudioParam cancelAndHoldAtTime (double ); };cancelTime

1.6.1. 属性

automationRate, 类型为 AutomationRate-

该

AudioParam的自动化速率。 默认值取决于实际的AudioParam; 有关每个单独AudioParam的默认值,请参见其描述。一些节点有附加的 自动化速率约束,如下所示:

AudioBufferSourceNode-

该

AudioParam的playbackRate和detune必须是 "k-rate"。 如果速率被更改为 "a-rate",必须抛出InvalidStateError异常。 DynamicsCompressorNode-

该

AudioParam的threshold,knee,ratio,attack, 和release必须是 "k-rate"。 如果速率被更改为 "a-rate",必须抛出InvalidStateError异常。 PannerNode-

如果

panningModel是 "HRTF", 则automationRate的设置对于任何AudioParam都被忽略。 同样地,设置automationRate对于任何AudioParam的AudioListener也会被忽略。在这种情况下,AudioParam的行为就像automationRate被设置为 "k-rate" 一样。

defaultValue, 类型为 float,只读-

该

value属性的初始值。 maxValue, 类型为 float,只读-

该参数可以接受的最大名义值。与

minValue一起,定义了该参数的 名义范围。 minValue, 类型为 float,只读-

该参数可以接受的最小名义值。与

maxValue一起,定义了该参数的 名义范围。 value, 类型为 float-

该参数的浮动值。此属性的初始值为

defaultValue。获取此属性时,返回

[[current value]]插槽的内容。请参阅 § 1.6.3 计算值,了解返回值的算法。设置此属性等效于将请求的值分配给

[[current value]]插槽,并调用 setValueAtTime() 方法,传递当前AudioContext的currentTime和[[current value]]。 如果setValueAtTime()抛出任何异常,则设置该属性时也会抛出相同的异常。

1.6.2. 方法

cancelAndHoldAtTime(cancelTime)-

这与

cancelScheduledValues()类似,都会取消所有调度的参数变化,取消的时间为大于或等于cancelTime。 然而,除此之外,发生在cancelTime时的自动化 值将被延续,直到引入其他自动化事件为止。在调用

cancelAndHoldAtTime()后,自动化运行时引入事件的时间点非常复杂。cancelAndHoldAtTime()方法的行为因此被以下算法指定。设 \(t_c\) 为cancelTime的值。 然后-

设 \(E_1\) 为时间 \(t_1\) 的事件(如果存在),其中 \(t_1\) 是满足 \(t_1 \le t_c\) 的最大值。

-

设 \(E_2\) 为时间 \(t_2\) 的事件(如果存在),其中 \(t_2\) 是满足 \(t_c \lt t_2\) 的最小值。

-

如果 \(E_2\) 存在:

-

如果 \(E_2\) 是线性或指数变化,

-

将 \(E_2\) 实质性地重写为相同类型的变化,结束时间为 \(t_c\),结束值为原始变化在时间 \(t_c\) 时的值。

-

转到第5步。

-

-

否则,转到第4步。

-

-

如果 \(E_1\) 存在:

-

如果 \(E_1\) 是

setTarget事件,-

在时间 \(t_c\) 隐式插入一个

setValueAtTime事件,其值为setTarget在时间 \(t_c\) 时的值。 -

转到第5步。

-

-

如果 \(E_1\) 是

setValueCurve事件,起始时间为 \(t_3\),持续时间为 \(d\)-

如果 \(t_c > t_3 + d\),转到第5步。

-

否则,

-

实质性地替换该事件为一个新的

setValueCurve事件,起始时间为 \(t_3\),持续时间为 \(t_c - t_3\)。 但这不是一个真正的替换;这个自动化必须确保生成与原始相同的输出,而不是使用不同持续时间计算的输出。(否则会导致值曲线采样略有不同,产生不同的结果。) -

转到第5步。

-

-

-

-

删除所有时间大于 \(t_c\) 的事件。

如果没有添加事件,那么

cancelAndHoldAtTime()调用后的自动化值将是原始时间轴在时间 \(t_c\) 时的常数值。AudioParam.cancelAndHoldAtTime() 方法的参数。 参数 类型 可空 可选 描述 cancelTimedouble✘ ✘ 取消所有先前调度的参数变化的时间。它与 AudioContext的currentTime属性使用相同的时间坐标系统。如果RangeError异常被抛出,则cancelTime不得为负数。如果cancelTime小于currentTime, 它会被限制为currentTime。返回类型:AudioParam -

cancelScheduledValues(cancelTime)-

取消所有计划的参数变化,取消时间大于或等于

cancelTime。 取消计划的参数变化意味着从事件列表中移除该计划事件。任何活跃的自动化,其 自动化事件时间 小于cancelTime的自动化也会被取消,这种取消可能会导致不连续,因为原始值(在自动化之前的值)会立即恢复。如果在cancelAndHoldAtTime()方法中调度的保持值在cancelTime之后,保持值也会被移除。对于

setValueCurveAtTime(), 设 \(T_0\) 和 \(T_D\) 分别为该事件的startTime和duration。 如果cancelTime在 \([T_0, T_0 + T_D]\) 范围内,则该事件将从时间轴中移除。参数列表:AudioParam.cancelScheduledValues() 方法。 参数 类型 可空 可选 描述 cancelTimedouble✘ ✘ 取消所有先前调度的参数变化的时间。它与 AudioContext的currentTime属性使用相同的时间坐标系统。如果RangeError异常被抛出,则cancelTime不得为负数。 如果cancelTime小于currentTime, 它会被限制为currentTime。返回类型:AudioParam exponentialRampToValueAtTime(value, endTime)-

调度一个指数连续的参数值变化,从上一个调度的参数值到给定的值。表示滤波器频率和播放速率的参数最好以指数方式变化,因为人类感知声音的方式是如此。

在时间间隔 \(T_0 \leq t < T_1\) (其中 \(T_0\) 是前一个事件的时间,\(T_1\) 是传入此方法的

endTime参数的时间),值将按以下公式计算:$$ v(t) = V_0 \left(\frac{V_1}{V_0}\right)^\frac{t - T_0}{T_1 - T_0} $$其中 \(V_0\) 是在时间 \(T_0\) 时的值,\(V_1\) 是传入此方法的

value参数的值。 如果 \(V_0\) 和 \(V_1\) 具有相反符号,或者 \(V_0\) 为零,则 \(v(t) = V_0\) 对于 \(T_0 \le t < T_1\)。这也意味着,指数变化到 0 是不可能的。可以使用

setTargetAtTime()方法来获得一个合适的时间常数,从而获得一个不错的近似。如果在此 ExponentialRampToValue 事件之后没有更多的事件,那么对于 \(t \geq T_1\),\(v(t) = V_1\)。

如果没有前置事件,则指数变化会像调用

setValueAtTime(value, currentTime)方法一样,其中value是当前属性值,currentTime是currentTime属性的上下文时间。如果前置事件是一个

SetTarget事件,那么 \(T_0\) 和 \(V_0\) 将从当前时间和SetTarget自动化的当前值中选择。即,如果SetTarget事件尚未开始,那么 \(T_0\) 是事件的开始时间,\(V_0\) 是事件开始前的值。在这种情况下,ExponentialRampToValue事件实际上替代了SetTarget事件。如果SetTarget事件已经开始,那么 \(T_0\) 是当前的上下文时间,\(V_0\) 是当前SetTarget自动化值的时间 \(T_0\)。在这两种情况下,自动化曲线是连续的。参数列表:AudioParam.exponentialRampToValueAtTime() 方法。 参数 类型 可空 可选 描述 valuefloat✘ ✘ 参数将在给定时间内指数变化到的值。如果此值为 0,必须抛出 RangeError异常。endTimedouble✘ ✘ 指数变化结束的时间,使用与 AudioContext的currentTime属性相同的时间坐标系统。如果endTime为负数或不是一个有限的数字,必须抛出RangeError异常。 如果 endTime 小于currentTime, 它会被限制为currentTime。返回类型:AudioParam linearRampToValueAtTime(value, endTime)-

安排参数值从之前计划的值线性连续变化到给定值。

在时间区间 \(T_0 \leq t < T_1\)(其中 \(T_0\) 是前一个事件的时间,\(T_1\) 是此方法传递的

endTime参数),值将计算为:$$ v(t) = V_0 + (V_1 - V_0) \frac{t - T_0}{T_1 - T_0} $$其中 \(V_0\) 是 \(T_0\) 时的值,\(V_1\) 是此方法传递的

value参数。如果此 LinearRampToValue 事件之后没有更多事件,那么对于 \(t \geq T_1\),\(v(t) = V_1\)。

如果没有前置事件,则线性坡道行为就像调用

setValueAtTime(value, currentTime)方法一样,其中value是当前属性值,currentTime是上下文的currentTime时间。如果前置事件是

SetTarget事件,那么 \(T_0\) 和 \(V_0\) 将从当前时间和SetTarget自动化的当前值中选择。也就是说,如果SetTarget事件尚未开始,\(T_0\) 是事件的开始时间,\(V_0\) 是事件开始前的值。在这种情况下,LinearRampToValue事件实际上替代了SetTarget事件。如果SetTarget事件已经开始,那么 \(T_0\) 是当前的上下文时间,\(V_0\) 是当前SetTarget自动化值的时间 \(T_0\)。在这两种情况下,自动化曲线是连续的。参数列表:AudioParam.linearRampToValueAtTime() 方法。 参数 类型 可空 可选 描述 valuefloat✘ ✘ 参数将在给定时间内线性变化到的值。 endTimedouble✘ ✘ 指数变化结束的时间,使用与 AudioContext的currentTime属性相同的时间坐标系统。如果endTime为负数或不是一个有限的数字,必须抛出RangeError异常。 如果 endTime 小于currentTime, 它会被限制为currentTime。返回类型:AudioParam setTargetAtTime(target, startTime, timeConstant)-

开始以给定的时间常数的速率指数接近目标值。在实现 ADSR 包络的“衰减”和“释放”部分时尤其有用。请注意,参数值在给定时间不会立即变化到目标值,而是逐渐变化。

在时间区间:\(T_0 \leq t\),其中 \(T_0\) 是

startTime参数:$$ v(t) = V_1 + (V_0 - V_1)\, e^{-\left(\frac{t - T_0}{\tau}\right)} $$其中 \(V_0\) 是初始值(

[[current value]]属性)在 \(T_0\)(startTime参数)时的值,\(V_1\) 等于target参数,\(\tau\) 是timeConstant参数。如果在此事件之后有

LinearRampToValue或ExponentialRampToValue事件,则行为如linearRampToValueAtTime()或exponentialRampToValueAtTime()中所描述。如果是其他事件,则SetTarget事件将在下一个事件发生时结束。参数列表:AudioParam.setTargetAtTime() 方法。 参数 类型 可空 可选 描述 targetfloat✘ ✘ 参数将在给定时间开始变化到的目标值。 startTimedouble✘ ✘ 指数接近将在给定时间开始,该时间使用与 AudioContext的currentTime属性相同的时间坐标系统。如果start为负数或不是一个有限的数字,必须抛出RangeError异常。 如果 startTime 小于currentTime, 它会被限制为currentTime。timeConstantfloat✘ ✘ 首次到达目标值的时间常数。这个值越大,过渡的时间就越慢。该值必须是非负的,否则必须抛出 RangeError异常。如果timeConstant为零,输出值会立即跳跃到最终值。更准确地说,timeConstant 是一个线性时间不变系统在响应阶跃输入时(从0到1的变化),需要达到 \(1 - 1/e\)(大约63.2%)所需的时间。返回类型:AudioParam setValueAtTime(value, startTime)-

在给定的时间调度一个参数值的变化。

如果在此

SetValue事件之后没有更多的事件, 那么对于 \(t \geq T_0\),\(v(t) = V\),其中 \(T_0\) 是startTime参数,\(V\) 是value参数。换句话说,值将保持不变。如果此

SetValue事件之后的下一个事件(时间为 \(T_1\))不是LinearRampToValue或ExponentialRampToValue类型, 那么对于 \(T_0 \leq t < T_1\):$$ v(t) = V $$换句话说,在此时间间隔内,值将保持不变,从而允许创建“阶跃”函数。

如果此

SetValue事件之后的下一个事件是LinearRampToValue或ExponentialRampToValue类型, 请参见linearRampToValueAtTime()或exponentialRampToValueAtTime(),分别。AudioParam.setValueAtTime() 方法的参数。 参数 类型 可空 可选 描述 valuefloat✘ ✘ 参数将在给定时间变为的值。 startTimedouble✘ ✘ 参数值将在给定时间变更的时刻,这个时间使用与 BaseAudioContext的currentTime属性相同的时间坐标系统。如果startTime为负数或不是有限数字,则必须抛出RangeError异常。如果 startTime 小于currentTime, 它会被限制为currentTime。返回类型:AudioParam setValueCurveAtTime(values, startTime, duration)-

在给定的时间和持续时间内设置一组任意的参数值。值的数量将被缩放以适应所需的持续时间。

令 \(T_0\) 为

startTime, \(T_D\) 为duration, \(V\) 为values数组, 和 \(N\) 为values数组的长度。那么,在时间间隔 \(T_0 \le t < T_0 + T_D\) 内,令:$$ \begin{align*} k &= \left\lfloor \frac{N - 1}{T_D}(t-T_0) \right\rfloor \\ \end{align*} $$然后通过线性插值计算 \(v(t)\),它介于 \(V[k]\) 和 \(V[k+1]\) 之间。

在曲线时间间隔结束后 (\(t \ge T_0 + T_D\)),值将保持在最终曲线值,直到出现下一个自动化事件(如果有的话)。

在时间 \(T_0 + T_D\) 隐式调用

setValueAtTime()方法,值为 \(V[N-1]\),以便后续的自动化从setValueCurveAtTime()事件的结束处开始。AudioParam.setValueCurveAtTime() 方法的参数。 参数 类型 可空 可选 描述 valuessequence<float>✘ ✘ 表示参数值曲线的 float 值序列。这些值将在给定的时间开始应用并持续指定的时间。调用此方法时,将为自动化目的创建曲线的内部副本。随后修改传入数组的内容不会影响 AudioParam。如果该属性是长度小于 2 的sequence<float>对象,必须抛出InvalidStateError异常。startTimedouble✘ ✘ 值曲线将应用的开始时间,与 AudioContext的currentTime属性的时间坐标系统相同。如果startTime为负数或不是有限数字,必须抛出RangeError异常。如果 startTime 小于currentTime, 它会被限制为currentTime。durationdouble✘ ✘ 值将根据 values参数计算的时间长度(以秒为单位)。如果duration不是严格正数或不是有限数字,必须抛出RangeError异常。返回类型:AudioParam

1.6.3. 值的计算

有两种不同类型的 AudioParam,

简单参数 和 复合参数。简单参数(默认)用于单独计算 AudioNode

的最终音频输出。

复合参数 是与其他 AudioParam

一起使用的

AudioParam,

用于计算一个值,该值随后用于计算 AudioNode

的输出。

computedValue 是最终控制音频 DSP 的值,并且在每个渲染时间量子期间由音频渲染线程计算。

AudioParam

值的过程分为两部分:

-

由音频渲染线程在每个 渲染量子 期间计算的最终值 paramComputedValue,控制音频 DSP。

这些值必须按如下方式计算:

-

paramIntrinsicValue 会在每个时间点进行计算,这个时间点的值要么是直接设置到

value属性的值,要么是如果此时有任何自动化事件(其时间在当前时间之前或等于当前时间),则根据这些事件计算的值。如果自动化事件在给定的时间范围内被移除,则 paramIntrinsicValue 的值将保持不变,并继续保留在其之前的值,直到直接设置value属性,或者在该时间范围内添加新的自动化事件。 -

在此 渲染量子 开始时,将

[[current value]]设置为 paramIntrinsicValue 的值。 -

paramComputedValue 是 paramIntrinsicValue 的值与 输入 AudioParam 缓冲区 的值之和。如果和为

NaN,则将其替换为defaultValue。 -

如果此

AudioParam是一个 复合参数,则与其他AudioParam一起计算其最终值。 -

将 computedValue 设置为 paramComputedValue。

名义范围 是一个 computedValue

的低值和高值,这个参数可以有效地具有这些值。对于 简单参数,computedValue 被夹紧到此参数的 简单名义范围 内。复合参数 在由它们所组成的不同 AudioParam

值计算之后,其最终值会被夹紧到它们的 名义范围。

当使用自动化方法时,夹紧仍然会被应用。 然而,自动化会像没有夹紧一样运行。 只有当自动化值应用于输出时,才会按上述方式进行夹紧。

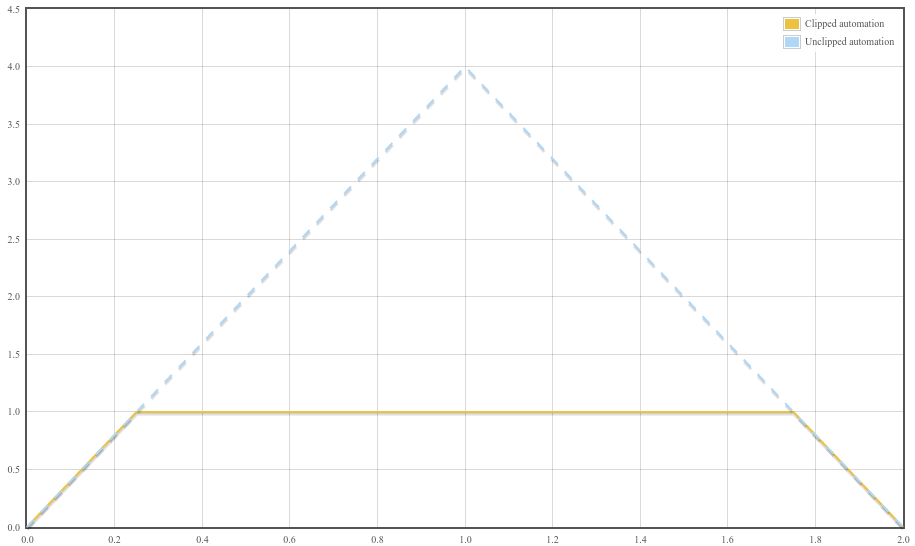

N. p. setValueAtTime( 0 , 0 ); N. p. linearRampToValueAtTime( 4 , 1 ); N. p. linearRampToValueAtTime( 0 , 2 );

曲线的初始斜率为 4,直到它达到最大值 1,此时输出保持不变。最后,在接近时间 2 时,曲线的斜率为 -4。下图展示了音频参数自动化的夹紧效果,虚线表示如果没有夹紧会发生的情况,实线表示由于夹紧到名义范围后音频参数的实际行为。

1.6.4. AudioParam

自动化示例

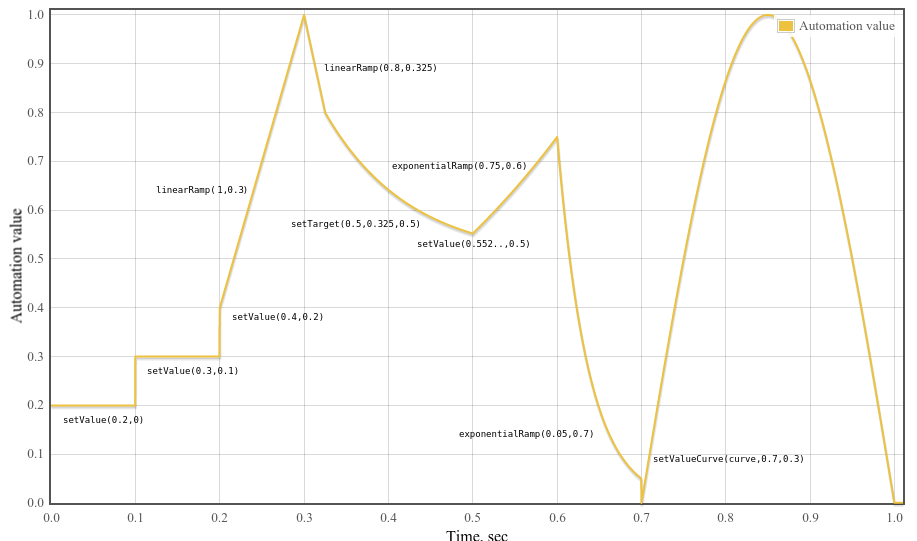

const curveLength= 44100 ; const curve= new Float32Array( curveLength); for ( const i= 0 ; i< curveLength; ++ i) curve[ i] = Math. sin( Math. PI* i/ curveLength); const t0= 0 ; const t1= 0.1 ; const t2= 0.2 ; const t3= 0.3 ; const t4= 0.325 ; const t5= 0.5 ; const t6= 0.6 ; const t7= 0.7 ; const t8= 1.0 ; const timeConstant= 0.1 ; param. setValueAtTime( 0.2 , t0); param. setValueAtTime( 0.3 , t1); param. setValueAtTime( 0.4 , t2); param. linearRampToValueAtTime( 1 , t3); param. linearRampToValueAtTime( 0.8 , t4); param. setTargetAtTime( .5 , t4, timeConstant); // Compute where the setTargetAtTime will be at time t5 so we can make // the following exponential start at the right point so there’s no // jump discontinuity. From the spec, we have // v(t) = 0.5 + (0.8 - 0.5)*exp(-(t-t4)/timeConstant) // Thus v(t5) = 0.5 + (0.8 - 0.5)*exp(-(t5-t4)/timeConstant) param. setValueAtTime( 0.5 + ( 0.8 - 0.5 ) * Math. exp( - ( t5- t4) / timeConstant), t5); param. exponentialRampToValueAtTime( 0.75 , t6); param. exponentialRampToValueAtTime( 0.05 , t7); param. setValueCurveAtTime( curve, t7, t8- t7);

1.7. AudioScheduledSourceNode

接口

该接口表示源节点的公共特性,例如 AudioBufferSourceNode、ConstantSourceNode

和 OscillatorNode。

在源节点开始之前(通过调用 start()),源节点必须输出静音(0)。在源节点停止之后(通过调用

stop()),源节点也必须输出静音(0)。

AudioScheduledSourceNode

不能直接实例化,而是由源节点的具体接口扩展。

一个 AudioScheduledSourceNode

被称为 正在播放,

当它关联的 BaseAudioContext

的

currentTime

大于或等于 AudioScheduledSourceNode

设置开始的时间,

且小于它设置停止的时间。

AudioScheduledSourceNode

通过内部布尔值槽 [[source started]]

创建,初始

值设置为 false。

[Exposed =Window ]interface AudioScheduledSourceNode :AudioNode {attribute EventHandler onended ;undefined start (optional double when = 0);undefined stop (optional double when = 0); };

1.7.1. 属性

onended, 类型为 EventHandler-

此属性用于为

ended事件类型设置一个 事件处理程序,该事件将在AudioScheduledSourceNode节点类型上触发。当源节点停止播放时(由具体节点确定),将触发一个使用Event接口的事件,并分发到事件处理程序。对于所有

AudioScheduledSourceNode, 当由stop()确定的停止时间达到时,ended事件被触发。 对于AudioBufferSourceNode, 该事件也会被触发,因为duration已经达到,或者整个buffer已经播放完成。

1.7.2. 方法

start(when)-

安排声音在准确的时间播放。

当调用此方法时,执行以下步骤:-

如果此

AudioScheduledSourceNode内部槽[[source started]]为真,则必须抛出InvalidStateError异常。 -

检查是否有由于下面描述的参数约束条件必须抛出的错误。如果在此步骤中抛出任何异常,则中止这些步骤。

-

将此

AudioScheduledSourceNode的内部槽[[source started]]设置为true。 -

队列一个控制消息 以启动

AudioScheduledSourceNode, 包括消息中的参数值。 -

仅当满足以下所有条件时,向相关联的

AudioContext发送一个 控制消息,以启动渲染线程:-

上下文的

[[control thread state]]为 "suspended"。 -

上下文被 允许启动。

-

[[suspended by user]]标志为false。

注意: 这可以允许

start()启动一个当前为 允许启动 的AudioContext, 但以前曾被阻止启动。 -

AudioScheduledSourceNode.start(when) 方法的参数。 参数 类型 可为空 可选 描述 whendouble✘ ✔ when参数描述了声音应该在何时(以秒为单位)开始播放。它与AudioContext的currentTime属性使用相同的时间坐标系统。当由AudioScheduledSourceNode发出的信号依赖于声音的开始时间时,when的确切值始终被使用,而不四舍五入到最近的采样帧。如果传递的值为 0 或小于currentTime,则声音将立即开始播放。如果when为负数,则必须抛出RangeError异常。返回类型:undefined -

stop(when)-

安排声音在准确的时间停止播放。如果在已调用

stop后再次调用,它会覆盖之前的调用,只有最后一次调用才会生效;除非缓冲区已经停止,否则之前设置的停止时间将不再生效。如果缓冲区已经停止,则后续调用stop将没有效果。如果停止时间在计划开始时间之前达到,则声音将不会播放。当调用此方法时,执行以下步骤:-

如果此

AudioScheduledSourceNode内部槽[[source started]]不是true,则必须抛出InvalidStateError异常。 -

检查是否有由于下面描述的参数约束条件必须抛出的错误。

-

队列一个控制消息 以停止

AudioScheduledSourceNode, 包括消息中的参数值。

AudioScheduledSourceNode.stop(when) 方法的参数。 参数 类型 可为空 可选 描述 whendouble✘ ✔ when参数描述了源应停止播放的时间(以秒为单位)。它与AudioContext的currentTime属性使用相同的时间坐标系统。如果此值为 0 或小于currentTime, 则声音将立即停止播放。如果when为负数,则必须抛出RangeError异常。返回类型:undefined -

1.8. AnalyserNode

接口

此接口表示一个能够提供实时频率和时域分析信息的节点。音频流将从输入传递到输出,未经处理。

| 属性 | 值 | 备注 |

|---|---|---|

numberOfInputs

| 1 | |

numberOfOutputs

| 1 | 此输出可以不连接。 |

channelCount

| 2 | |

channelCountMode

| "max"

| |

channelInterpretation

| "speakers"

| |

| tail-time | 没有 |

[Exposed =Window ]interface AnalyserNode :AudioNode {constructor (BaseAudioContext ,context optional AnalyserOptions = {});options undefined getFloatFrequencyData (Float32Array );array undefined getByteFrequencyData (Uint8Array );array undefined getFloatTimeDomainData (Float32Array );array undefined getByteTimeDomainData (Uint8Array );array attribute unsigned long fftSize ;readonly attribute unsigned long frequencyBinCount ;attribute double minDecibels ;attribute double maxDecibels ;attribute double smoothingTimeConstant ; };

1.8.1. 构造函数

AnalyserNode(context, options)-

当构造函数使用

BaseAudioContextc 和一个选项对象 option 被调用时,用户代理必须 初始化 AudioNode this,并将 context 和 options 作为参数。Arguments for the AnalyserNode.constructor() 方法。 参数 类型 可空 可选 描述 contextBaseAudioContext✘ ✘ 新的 AnalyserNode将会与该BaseAudioContext关联。optionsAnalyserOptions✘ ✔ 此 AnalyserNode的可选初始参数值。

1.8.2. 属性

fftSize, 类型为 unsigned long-

用于频域分析的FFT大小(以样本帧为单位)。此值必须是2的幂,范围为32到32768,否则必须抛出

IndexSizeError异常。默认值为2048。请注意,较大的FFT大小可能需要耗费更多的计算资源。如果

fftSize更改为不同的值, 那么与频率数据平滑相关的所有状态(如getByteFrequencyData()和getFloatFrequencyData()) 将被重置。也就是说,用于 前一个块,\(\hat{X}_{-1}[k]\), 用于 时间平滑的值将被设为0,适用于所有\(k\)。请注意,增大

fftSize意味着 当前时域数据 必须扩展,以包括之前没有的过去帧。 这意味着AnalyserNode必须保留最后的32768个样本帧,并且 当前时域数据 是这些帧中最近期的fftSize个样本帧。 frequencyBinCount, 类型为 unsigned long,只读-

FFT大小的一半。

maxDecibels, 类型为 double-