enum AppendMode {

"segments",

"sequence",

};

-

segments

-

媒体分段中的时间戳决定了编码帧

在演示中的位置。媒体分段可以以任意顺序追加。

-

sequence

-

媒体分段将被视为时间上相邻,和分段中的时间戳无关。新媒体分段中的编码帧会紧接在前一个媒体分段的编码帧之后。若需要使新媒体分段和前一个分段相邻,会更新

timestampOffset 属性。设置 "sequence" 模式下的 timestampOffset

属性,可以让媒体分段放到时间线上的指定位置,而无需了解分段内时间戳。

[Exposed=(Window,DedicatedWorker)]

interface SourceBuffer : EventTarget {

attribute AppendMode mode;

readonly attribute boolean updating;

readonly attribute TimeRanges buffered;

attribute double timestampOffset;

readonly attribute AudioTrackList audioTracks;

readonly attribute VideoTrackList videoTracks;

readonly attribute TextTrackList textTracks;

attribute double appendWindowStart;

attribute unrestricted double appendWindowEnd;

attribute EventHandler onupdatestart;

attribute EventHandler onupdate;

attribute EventHandler onupdateend;

attribute EventHandler onerror;

attribute EventHandler onabort;

undefined appendBuffer(BufferSource data);

undefined abort();

undefined changeType(DOMString type);

undefined remove(double start, unrestricted double end);

};

Issue

280: MSE-in-Workers: {Audio,Video,Text}Track{,List} IDL in

HTML 需要补充 DedicatedWorker 的 Exposed mse-in-workers

当向此 SourceBuffer 追加新数据时,运行此算法以释放空间。

- 令 new data 为即将追加到此 SourceBuffer 的数据。

Issue 289:

编辑?编码帧清除算法需要注意“缓冲区满标志”可能会根据 |new data| 立即更新

- 如果

[[buffer full flag]] 等于 false,则中止这些步骤。

- 令 removal ranges 为可以从展示中清除以为 new data 腾出空间的展示时间范围列表。

注意

实现 可以 采用不同方法选择 removal

ranges,

因此 Web 应用 不应 依赖特定行为。Web 应用可使用 buffered 属性观察缓冲数据是否已被清除。

- 对 removal ranges 中的每个范围,运行 编码帧移除算法,

其中 start 和 end

分别为移除范围的起止时间戳。

当 编码帧处理算法需要为两个重叠的音频 编码帧 生成拼接帧时,按照以下步骤操作:

- 令 track buffer 为将包含拼接的 轨道缓冲区。

- 令 new coded frame 为即将被添加到 track buffer 的新 编码帧,它触发了拼接需求。

- 令 presentation timestamp 为 new coded frame 的 展示时间戳。

- 令 decode timestamp 为 new coded frame 的解码时间戳。

- 令 frame duration 为 new coded frame 的 编码帧时长。

- 令 overlapped frame 为 track buffer 中展示区间包含 presentation timestamp 的 编码帧。

- 将 presentation timestamp 和 decode

timestamp 更新为基于 overlapped frame

音频采样率最近的音频采样时间戳。如果时间戳距离两个采样时间戳等距,则用较大的时间戳(例如,

floor(x * sample_rate + 0.5) / sample_rate)。

注意

例如,给定如下值:

- overlapped frame 的 展示时间戳 等于 10。

- overlapped frame 的采样率为 8000 Hz

- presentation timestamp 等于 10.01255

- decode timestamp 等于 10.01255

presentation timestamp 和 decode timestamp 被更新为 10.0125,因为 10.01255 更接近于 10 +

100/8000 (10.0125),而不是 10 + 101/8000 (10.012625)

- 如果用户代理不支持淡入淡出,则运行以下步骤:

- 从 track buffer 移除 overlapped frame。

- 向 track buffer 添加一个静音帧,属性如下:

注意

一些实现 可以 对插入静音帧两侧的编码帧应用淡入淡出处理,使过渡不那么突兀。

- 无需返回拼接帧,直接返回给调用方。

注意

这样可使 new coded frame 能被添加到 track buffer,仿佛 overlapped

frame 起初就不在 track buffer 中一样。

- 令 frame end timestamp 为 presentation

timestamp 与 frame duration 之和。

- 令 splice end timestamp 为 presentation

timestamp 与拼接时长(5 毫秒)之和。

- 令 fade out coded frames 为 overlapped frame 以及 track buffer 中所有

展示时间戳 大于 presentation

timestamp 且小于 splice end timestamp 的其他帧。

- 从 track buffer 中移除 fade out coded frames 中的所有帧。

- 返回一个拼接帧,属性如下:

- 展示时间戳 设为 overlapped frame 的 展示时间戳。

- 解码时间戳 设为 overlapped frame 的 解码时间戳。

- 编码帧时长 设为 frame

end timestamp

与 overlapped frame 的 展示时间戳 的差值。

- 淡出编码帧为 fade out coded frames。

- 淡入编码帧为 new coded frame。

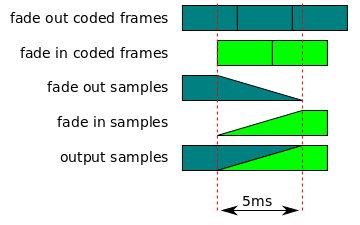

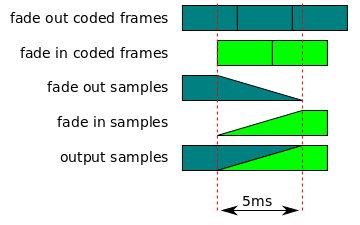

注意

如果 new coded frame 的时长小于 5 毫秒,则在 new coded frame

之后追加的编码帧将被用于正确渲染拼接。

- 拼接时间戳为 presentation timestamp。

注意

有关该拼接帧如何被渲染的详细信息,参见 音频拼接渲染 算法。

当由 音频拼接帧算法生成的拼接帧需要由媒体元素进行渲染时,运行以下步骤:

- 令 fade out coded frames 为拼接过程中被淡出的 编码帧。

- 令 fade in coded frames 为拼接过程中被淡入的 编码帧。

- 令 presentation timestamp 为 fade out coded frames

中第一个编码帧的 展示时间戳。

- 令 end timestamp 为 fade in coded frames 中最后一个帧的 展示时间戳 加上该帧的 编码帧时长。

- 令 splice timestamp 为拼接开始的 展示时间戳,即 fade in coded frames

的第一个帧的展示时间戳。

- 令 splice end timestamp 等于 splice

timestamp 加五毫秒。

- 令 fade out samples 为解码 fade out coded frames 后生成的音频采样。

- 裁剪 fade out samples,使其只包含 presentation timestamp 到 splice end timestamp 之间的采样。

- 令 fade in samples 为解码 fade in coded frames 后生成的音频采样。

- 如果 fade out samples 和 fade in samples 没有共同的采样率和声道布局,则将其转换为统一的采样率和声道布局。

- 令 output samples 为用于存放输出采样的缓冲区。

- 对 fade out samples 中 splice timestamp 到 splice end timestamp 的采样应用线性增益淡出,起始增益为 1,结束增益为 0。

- 对 fade in samples 中 splice timestamp 到 splice end timestamp 的采样应用线性增益淡入,起始增益为 0,结束增益为 1。

- 将 fade out samples 中 presentation timestamp 到 splice timestamp 之间的采样复制到 output samples。

- 对 splice timestamp 到 splice end

timestamp 之间的每个采样,计算 fade out samples 与 fade in samples

的相应采样之和,并存储到 output samples。

- 将 fade in samples 中 splice end timestamp 到 end timestamp 之间的采样复制到 output samples。

- 渲染 output samples。

注意

以下是该算法的图示。

当 编码帧处理算法需要为两个重叠的定时文本 编码帧 生成拼接帧时,运行以下步骤:

- 令 track buffer 为将包含拼接的 轨道缓冲区。

- 令 new coded frame 为即将被添加到 track buffer 的新 编码帧,它触发了拼接需求。

- 令 presentation timestamp 为 new coded frame 的 展示时间戳。

- 令 decode timestamp 为 new coded frame 的解码时间戳。

- 令 frame duration 为 new coded frame 的 编码帧时长。

- 令 frame end timestamp 为 presentation

timestamp 与 frame duration 之和。

- 令 first overlapped frame 为 track buffer 中展示区间包含 presentation timestamp 的 编码帧。

- 令 overlapped presentation timestamp 为 first overlapped

frame 的 展示时间戳。

- 令 overlapped frames 为 first overlapped frame 以及 track buffer

中所有 展示时间戳 大于 presentation

timestamp 且小于 frame end timestamp 的其他帧。

- 从 track buffer 中移除 overlapped frames 中的所有帧。

- 将 first overlapped frame 的 编码帧时长 更新为 presentation

timestamp 减去 overlapped presentation timestamp 的值。

- 将 first overlapped frame 添加到 track buffer。

- 无需返回拼接帧,直接返回给调用方。

注意

这样可使 new coded frame 能被添加到 track buffer,仿佛它起初就没有与 track

buffer 中的任何帧重叠。

本节对 [HTML]

中 TextTrack

的定义进行扩展。

编辑们感谢 Alex Giladi、Bob Lund、Chris Needham、Chris Poole、Chris

Wilson、Cyril Concolato、Dale Curtis、David Dorwin、David Singer、Duncan Rowden、François

Daoust、Frank Galligan、Glenn Adams、Jer Noble、Joe Steele、John Simmons、Kagami Sascha

Rosylight、Kevin Streeter、Marcos Cáceres、Mark Vickers、Matt Ward、Matthew Gregan、

Michael(tm) Smith、Michael Thornburgh、Mounir Lamouri、Paul Adenot、Philip Jägenstedt、

Philippe Le Hegaret、Pierre Lemieux、Ralph Giles、Steven Robertson 与 Tatsuya Igarashi

对本规范所作的贡献。

- Issue 276: MSE-in-Workers:

考虑添加 “closing” readyState 来解释关闭进行中时新的 `InvalidStateError` 异常

- Issue 280: MSE-in-Workers:

{Audio,Video,Text}Track{,List} 在 HTML 中的 IDL 需要在 Exposed 中增加 DedicatedWorker

- Issue 289: 编辑性?编码帧

清除算法需要说明 “buffer full flag” 可能会基于 |new data| 立即更新

- Issue 277: MSE-in-Workers:

当 MediaSource 的 worker 终止时,考虑(最终)让附加元素转为错误状态/媒体元素应如何处理?

- Issue 277:

MSE-in-Workers:当 MediaSource 的 worker 终止时,考虑(最终)让附加元素转为错误状态/媒体元素应如何处理?

- Issue

- Issue 280:

MSE-in-Workers:{Audio,Video,Text}Track{,List} 在 HTML 中的 IDL 需要在 Exposed 中增加 DedicatedWorker

- Issue 280:

MSE-in-Workers:{Audio,Video,Text}Track{,List} 在 HTML 中的 IDL 需要在 Exposed 中增加 DedicatedWorker

- Issue 280:

MSE-in-Workers:{Audio,Video,Text}Track{,List} 在 HTML 中的 IDL 需要在 Exposed 中增加 DedicatedWorker

↑

Referenced in:

- Not referenced in this document.

Referenced in:

- Not referenced in this document.

Referenced in:

- Not referenced in this document.

Referenced in:

- Not referenced in this document.

Referenced in:

- Not referenced in this document.